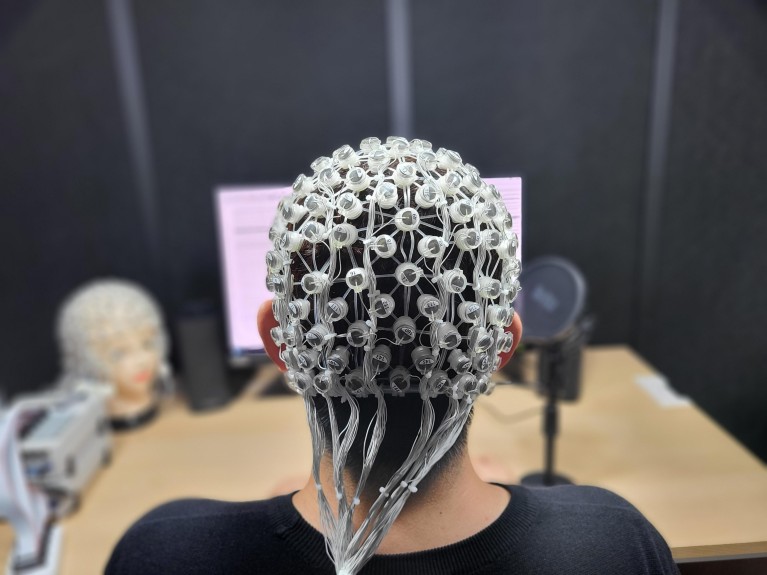

位于头皮上的脑电图(EEG)电极用来捕捉大脑信号。

尽管智能手机和社交媒体在我们的生活中变得越来越不可或缺,但口头交流仍然是人们最常见的互动方式。然而,有些人天生就没有说话的能力,或者可能因为身体残疾或疾病而突然失去说话的能力。

现在,将大脑活动转换为语音或文本的技术的进步正在为通过大脑信号进行交流铺平道路,这可能提供一种无语音和免提的交流方式,并极大地改善残疾人的生活。

自20世纪90年代以来,神经学家和计算机科学家一直在使用人工智能弥合人们的思想和他们希望采取的行动之间的差距。脑机接口(BCI)使用当一个人想象一些事情时产生的电信号,比如移动他们的手臂,来控制外部设备,比如机械臂。

使用脑电图(EEG)可以无创地测量大脑信号,这是一种将电极放在头皮上的方法。

对大脑的好奇

“作为一名年轻的学生,我总是对大脑是如何工作的感到好奇,”韩国首尔高丽大学大脑与认知工程系的神经工程师李瑞贤(音译)说。“但作为一名博士生,我想做的不仅仅是揭开它的奥秘。通过识别由思考特定单词引发的大脑活动,我希望我们可以创造一种技术,帮助那些不能说话或失去说话能力的人。”

由于脑电图数据噪声极大,将大脑信号转换为自然语音具有挑战性,因此,开发能够从数据中提取关键特征的高级人工智能非常重要。

通过手术植入的电极捕捉到的信号,或者当病人大声说话时,已经成功地产生了语言。然而,要使“无声对话”在我们的生活中得到更广泛的应用,比如在电脑上生成文本,而不需要在键盘上打字,更简单、更少侵入性的技术将是至关重要的。高丽大学(Korea University)人工智能和大脑工程教授李成焕(Seong-Whan Lee)表示:“我们现在对不需要在大脑中植入电极、只通过想象的语言就能生成声音非常感兴趣。”

“想象讲话”是指某人想象说话时不发出声音(“口语讲话”)或模仿单词(“默念讲话”)。

Lee的实验室得到了美国信息与通信技术规划与评估研究所(IITP)的资助,专门研究模式识别和机器学习,重点关注与语音相关的大脑信号模式。“我们研究的主要目的是利用这些模式来分析一个人在想什么,并预测他想说什么,”李说。“目前的BCI技术主要是基于文本和音频,但未来我们希望使用来自想象语音的大脑信号,因为这些信号可以非常直接和直观。”

深思熟虑的方法

脑语音转换技术结合了人工智能的几个关键领域,包括:BCI;从复杂的大脑信号中捕捉重要特征的深度学习工具;还有语音合成技术。在这样的系统中,一个人想象着说“你好吗?”,脑电图记录由该思想产生的信号,深度学习模型从大脑信号中解码信息的特征,最后利用提取的特征合成用户的语音。

韩国高丽大学的Seong-Whan Lee、Seo-Hyun Lee和他们的团队开发了一种脑语音转换技术,可以从非侵入性测量EEG记录的想象语音信号中识别并生成12个单词。这代表着大脑语音应用的重要一步,因为之前的研究只涉及到对几个单词进行分类,团队必须克服重大挑战。

高丽大学的一位科学家正在观察脑电图实验。

“通过头皮记录电信号使得识别语音信号变得更加困难,因为头发和皮肤会引入大量人工制品,所以我们必须开发出一种去除它们的方法。”soo - hyun Lee说。她补充说:“从好的方面来说,想象的讲话比默剧和口语产生的人工制品更少,因为没有动作。”

另一个问题是,与口头讲话不同,想象讲话没有人工智能可以核对的声音记录,也没有训练语音合成器所需的音频。“我们需要在大脑信号中识别想象语言的确切起始点,并将这些信号与相应用户的声音相匹配,”soo - hyun Lee说。

为了发现这些独特的信号,Seong-Whan Lee的团队收集了一个大型的想象和口头语音信号数据库,这些信号使用了患者交流中常用的12个单词,如“帮助我”和“谢谢”。参与者被绑在头皮电极帽上,进行三次实验,反复大声说出一个词,反复想象说这个词,反复想象看到这个词。然后,该团队使用人工智能模型在记录的脑电图信号中寻找模式,并学习将它们与什么单词和声音联系起来。

“我们观察到这两种语言之间的共同特征,比如电信号的时间、位置和强度,以及相似的空间模式,两种语言照亮了左侧颞叶和额叶皮层的相似区域,”李瑞贤说。

她补充说:“我们通过对比脑电图结果和视觉图像信号,进一步研究了想象语言的内在特征。在视觉图像信号中,参与者只是想象一个单词的图片,比如一个时钟。”“有趣的是,它们之间也显示出了显著的相关性,单词集群产生了类似的信号。”1

利用最优特征,他们的模型能够区分信号之间的细微差异,并成功地从想象的语音中识别出12个单词。此外,他们的人工智能模型可以成功地将想象语音的脑电图转换为具有用户自己声音的合成语音。

Brain-to-speech技术

该团队正在研究一个虚拟原型,以突出将人工智能与信息和通信技术、大数据和机器人技术结合在智能家居中的潜力,这样残疾人将能够通过简单的思维控制他们的供暖、照明、娱乐和家电。

Lee soo - hyun说:“从想象的言语中合成单词级别之外的听起来自然的完整句子,我们还有一段路要走,但我们一直在寻找潜在的方法来提高我们的技术。”她希望他们能在未来十年实现这一目标,从而开始对患者的生活产生积极影响。

“残疾人或患有肌萎缩性侧索硬化症(ALS)等疾病的人最终可能会失去说话的能力,”徐铉·李(音译)说。“大脑语音转换技术可以在他们还能说话的时候就记录下他们的谈话,这样他们有一天就能再用自己的声音说话了。”

人工智能和机器人

人工智能和机器人