文摘gydF4y2Ba

监测生物多样性是至关重要的管理和保护自然资源。收集图像的生物在大的时间和空间尺度上的是一个有前途的实践监控自然生态系统的生物多样性,提供大量的数据以最小的干扰环境。深度学习模型是目前用于自动化生物分类成分类单元。然而,在这些分类器引入了测量噪声不精确,很难控制和可以极大地阻碍了数据的分析和解释。我们克服这种限制通过乐团Data-efficient图像的变形金刚(DeiTs),我们可以达到最先进的展示(SOTA)表演没有hyperparameter调优,如果遵循一个简单的固定的训练计划。我们验证结果十生态成像数据集不同的起源,从浮游生物到鸟。的表演EDeiTs总是与前SOTA可比,甚至在四个的情况下击败它。我们认为这些合奏DeiTs表现更好,不是因为优越的单模表演,而是由于小重叠由独立模型和预测(概率较低,从而增加整体的利益。gydF4y2Ba

介绍gydF4y2Ba

生物多样性监测是至关重要的,因为它可以作为评估的基础生态系统完整性、干扰反应,保护和恢复工作的有效性gydF4y2Ba1gydF4y2Ba,gydF4y2Ba2gydF4y2Ba,gydF4y2Ba3gydF4y2Ba。gydF4y2Ba传统上,生物多样性监测依赖手工收集的经验数据gydF4y2Ba4gydF4y2Ba。这是费时、劳动密集型和昂贵。此外,这些数据可以包含抽样偏差由于困难控制观察者观察者存在主观性和动物的反应gydF4y2Ba5gydF4y2Ba。这些约束严重限制我们的能力来估计自然种群的丰度和社区的多样性,减少我们解释他们的动态和交互的能力。计数的野生动物被人类倾向于大大低估个人的数量gydF4y2Ba6gydF4y2Ba,gydF4y2Ba7gydF4y2Ba。此外,人口估计基于推断从少量的点数量受到大量的不确定性和可能无法代表时空变化的生态相互作用(如捕食者-猎物),导致不准确的预测或推断gydF4y2Ba7gydF4y2Ba,gydF4y2Ba8gydF4y2Ba。而人性化提供基础数据收集有着悠久的历史的大部分时间里,我们的知识在哪里以及为什么动物栖息的地方,以及他们如何相互作用,目前的困难在野生动物生态学和保护暴露的传统监测方法的局限性gydF4y2Ba7gydF4y2Ba。gydF4y2Ba

最近改善成像技术大大提高了数据采集能力通过降低成本和扩大范围和覆盖与传统方法相比,开放大规模生态研究的新路径gydF4y2Ba7gydF4y2Ba。许多以前无法进入的地方保护利益现在可能通过使用高分辨率遥感研究gydF4y2Ba9gydF4y2Ba和数字技术,如相机陷阱gydF4y2Ba10gydF4y2Ba,gydF4y2Ba11gydF4y2Ba,gydF4y2Ba12gydF4y2Ba方法收集海量数据。相机陷阱是低成本、简单的设置,并提供高分辨率图像序列的物种,允许研究人员识别动物物种,它们的行为,和交互包括捕食、竞争和便利化。几个摄像头已经被用于监测生物多样性在世界各地,包括水下系统gydF4y2Ba13gydF4y2Ba,gydF4y2Ba14gydF4y2Ba,使相机陷阱的一个最广泛使用的传感器gydF4y2Ba12gydF4y2Ba。在生物多样性保护行动,相机陷阱成像正迅速成为黄金标准gydF4y2Ba10gydF4y2Ba,gydF4y2Ba11gydF4y2Ba,因为它使无与伦比的精密监测在巨大的广阔的土地。gydF4y2Ba

然而,人们发现它挑战来分析这些设备提供的大量数据。现代所产生的海量的图像数据采集技术生态研究在规模太大了,被处理和分析得出令人信服的生态的结论gydF4y2Ba15gydF4y2Ba。虽然网络众包平台可用于注释的图像gydF4y2Ba16gydF4y2Ba,这样的系统是不可持续的指数的数据采集和扩张所需的专业知识不足,通常是注释。换句话说,我们需要工具,可以自动从数据中提取相关信息,有助于准确理解生态过程在时间和空间。gydF4y2Ba

机器学习已经被证明是一个合适的方法来解决生态观点从大量的数据gydF4y2Ba17gydF4y2Ba。检测和计算管道已经从手工计算不精确的推断基于机器学习系统具有高检测率gydF4y2Ba18gydF4y2Ba,gydF4y2Ba19gydF4y2Ba,gydF4y2Ba20.gydF4y2Ba。使用深度学习(DL)检测和分类的物种为目的的人口估计正变得越来越普遍gydF4y2Ba18gydF4y2Ba,gydF4y2Ba19gydF4y2Ba,gydF4y2Ba20.gydF4y2Ba,gydF4y2Ba21gydF4y2Ba,gydF4y2Ba22gydF4y2Ba,gydF4y2Ba23gydF4y2Ba,gydF4y2Ba24gydF4y2Ba,gydF4y2Ba25gydF4y2Ba,gydF4y2Ba26gydF4y2Ba,gydF4y2Ba27gydF4y2Ba。DL模型,通常与卷积神经网络(CNN)的架构gydF4y2Ba18gydF4y2Ba,gydF4y2Ba19gydF4y2Ba,gydF4y2Ba20.gydF4y2Ba,gydF4y2Ba22gydF4y2Ba,gydF4y2Ba24gydF4y2Ba,gydF4y2Ba26gydF4y2Ba迄今为止,标准的生物多样性监测。虽然这些模型有一个可接受的性能,他们经常不可靠检测少数类gydF4y2Ba22gydF4y2Ba剪裁精良,需要一个模型选择和培训,大量数据gydF4y2Ba20.gydF4y2Ba,有一个可观的错误率,负面影响的建模和解释输出数据。于是,认为许多DL-based监测系统无法部署在一个全自动的方式如果想确保足够可靠的分类gydF4y2Ba28gydF4y2Ba,gydF4y2Ba29日gydF4y2Ba。gydF4y2Ba

最近,成功后在自然语言处理的应用程序gydF4y2Ba30.gydF4y2Ba变压器结构,适应计算机视觉应用。由此产生的结构,称为视觉变形金刚(vit)gydF4y2Ba31日gydF4y2Ba不同于CNN-based模型,利用图像像素单元的信息,使用图像补丁,雇佣一个注意力机制来衡量输入数据的每个部分的重要性不同。视觉变形金刚了令人鼓舞的结果在几个计算机视觉任务,超越艺术的状态(SOTA)在几个典型数据集,并铺平了道路新深度学习的研究领域内的分支。gydF4y2Ba

在本文中,我们使用一种特定的维特,数据有效的图像变形金刚(DeiTs)gydF4y2Ba32gydF4y2Ba生物多样性的分类图像,如浮游生物,珊瑚礁,昆虫,鸟类和大型动物(虽然我们的方法也可以应用在不同的领域)。我们表明,单模DeiTs的性能匹配的替代方法,集合DeiTs (EDeiTs)实现很好的表演,而无需任何hyperparameter调优。我们看到,这主要是因为更高的分歧的预测,对其他模型类,独立DeiT之间的模型。gydF4y2Ba

结果gydF4y2Ba

一个新的国家的艺术gydF4y2Ba

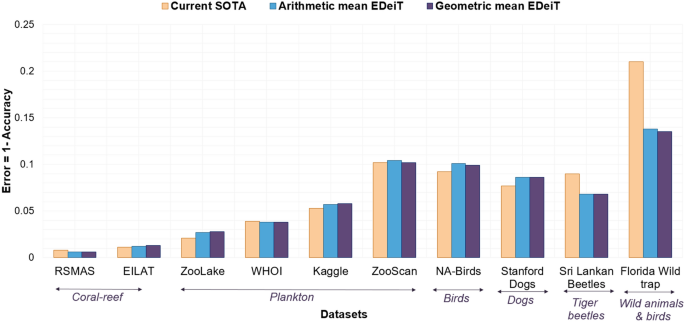

我们训练EDeiTs几个生态数据集,包括从微生物到大型动物,包括彩色和黑白图像,有或没有背景;和包括不同大小的数据集和不同数量的类,平衡和不平衡。细节部分中提供的数据集”gydF4y2Ba数据gydF4y2Ba”。如无花果所示。gydF4y2Ba1gydF4y2Ba的错误率EDeiTs有时甚至接近或小于先前SOTA。如果,我们提供一个详细的对比模型的准确性和F1-score和前面的SOTA。细节模型和训练提供了部分”gydF4y2Ba模型gydF4y2Ba”、“gydF4y2Ba实现gydF4y2Ba”和“gydF4y2Ba整体学习gydF4y2Ba”。gydF4y2Ba

单个模型的比较gydF4y2Ba

我们现在展示的更好的性能EDeiTs不是单一模型的属性,但它,而源于合奏的一步。要做到这一点,我们关注ZooLake数据集的前CNN的艺术是一个整体的状态模型gydF4y2Ba22gydF4y2Ba,包括EfficientNet MobileNet和DenseNet架构。在表gydF4y2Ba1gydF4y2Ba我们展示这些体系结构的单模表演,和那些DeiT-Base模型(“gydF4y2Ba实现gydF4y2Ba”一节),这是我们用于图中的结果。gydF4y2Ba1gydF4y2Ba。的精度和(macro-averaged) F1-scores模型的两个家庭(CNN和DeiT)相比单独在一个相似的范围:精度在0.96和0.97之间,F1-scores在0.86和0.90之间。gydF4y2Ba

整体比较gydF4y2Ba

我们训练每个cnn的表gydF4y2Ba1gydF4y2Ba(引用文献中描述的四倍。gydF4y2Ba22gydF4y2Ba),不同的初始条件,实现。并展示他们的算术平均合奏和几何平均合奏(“gydF4y2Ba整体学习gydF4y2Ba”一节)在过去的两列。我们也显示整体的性能模型开发的参考。gydF4y2Ba22gydF4y2Ba乐团在CNN架构所示的六个。我们比较的合奏DeiT-Base模型,通过算术平均合奏和几何平均搭配三种不同初始条件模型的权重。gydF4y2Ba

可以预期,在合奏个体模型性能提高了理智。然而,在所有模型改进是不一样的。CNN家族达到最大F1-score≤0.920合奏Efficient-B7网络的初始条件。最好的cnn采摘及乐团合奏的性能(Best_6_avg)达到F1-score≤0.924。DeiT模型,进行了整体没有选择最好的模型在不同DeiTs但仍达到类似的分类精度达到0.924)(F1-score没有hyperparameter调优。gydF4y2Ba

为什么DeiT模型整体更好gydF4y2Ba

理解的更好的性能DeiTs合奏时,我们比较cnn DeiTs合奏时三种模式。cnn,我们把最好的EfficientNet-B7 MobileNet Ref和Dense121模型。gydF4y2Ba22gydF4y2Ba(每个有最好的验证性能从4独立运行)。DeiTs,我们三次火车DeiT-Base模型(不同的初始重量配置),在这三个合奏。gydF4y2Ba

以来唯一平均整体考虑的信心向量模型,我们确定了两种可能的原因EDeiTs表现更好,尽管单模性能等于cnn:gydF4y2Ba

- (一)gydF4y2Ba

不同的CNN模型倾向于同意相同的比DeiTs经常错误的答案。gydF4y2Ba

- (b)gydF4y2Ba

信心的DeiT预测更适合系综平均比其他模型。gydF4y2Ba

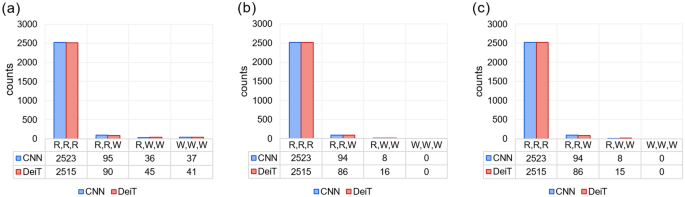

我们将看到(a)和(b)是真的,虽然主要贡献来自于(a)。在无花果。gydF4y2Ba2gydF4y2Ba我们显示多少的直方图模型对(R)或错了(W)预测(gydF4y2Ba如。gydF4y2Ba存款准备金率是指在个体模型中三个正确的预测,弹头表示一个错误,等等)。gydF4y2Ba

在无花果。gydF4y2Ba2gydF4y2Bab和c,我们显示相同的数量,但是限制的例子是由算术和几何平均正确分类的整体模型。CNN合奏有更多存款准备金率情况下比EDeiT(2523)(2515),但当这三个模型有一些分歧,EDeiTs赶上CNN集合体gydF4y2Ba

特别是:gydF4y2Ba

正确的读写网情况下2.0 x更常见的几何平均和算术平均EDeiT(几何EDeiT几何CNN: 8日:15;算术运算CNN: 8日EDeiT: 16)。在SI(见脚注1)表明,读写网系综的概率在一个正确的预测结果取决于之间的比例的第二个和第三个组件ensembled向量,信心和DeiT集合体的更好的性能在这种情况下是合理的,信心的形状向量。我们因此测量不同模型之间的共同协议。为此,我们把信心向量,gydF4y2Bavec c_0 \ (\ \)gydF4y2Ba,gydF4y2Bavec c₁\ (\ \)gydF4y2Ba和gydF4y2Bavec₂\ (\ \)gydF4y2Ba的三个模型,计算相似度gydF4y2Ba

DeiTs平均在整个测试集。,gydF4y2Ba\ (S = 0.799 \ \ 0.004点)gydF4y2Ba,而对于cnn相似性更高,gydF4y2Ba\ (S = 0.945 \ \ 0.003点)gydF4y2Ba。这是我们使用独立的CNN模型。如果我们合奏Eff2, Eff5 Eff6,我们获得gydF4y2Ba\ (S = 0.948 \ \ 0.003点)gydF4y2Ba。注意,低相关性预测不同DeiT学习者更引人注目的是,鉴于我们是比较gydF4y2Ba相同gydF4y2BaDeiT模型训练三次,gydF4y2Ba不同的gydF4y2BaCNN的架构。这表明,CNN预测关注图像的相似的特性,所以当他们失败,所有的模型同样失败。相反,独立的预测DeiTs更独立。给定一个单模正确答案固定预算,读写网的组合结果更有可能在一个正确的答案两个错误答案是不同的(参见SI(见脚注1))。的情况是类似的几何平均(图。gydF4y2Ba2gydF4y2Bac)。gydF4y2Ba

比较香草维特:出于完整性的考虑,在SI(见脚注1)我们还提供DeiTs之间的比较gydF4y2Ba32gydF4y2Ba和香草维特gydF4y2Ba31日gydF4y2Ba。还在这里,我们发现类似的结果:尽管单模性能相似,DeiTs合奏更好,又可以归因于来自独立预测模型之间的相似性较低。这表明DeiT集合体的更好的性能与维特的注意机制,而是DeiTs的蒸馏过程的特征(“gydF4y2Ba模型gydF4y2Ba”一节)。gydF4y2Ba

讨论gydF4y2Ba

我们提出的各个数据有效的图像变形金刚(EDeiTs)作为图像分类标准的首选方法。尽管我们提出的方法是有效的任何类型的图像,我们提供了一个概念验证它的有效性与生物多样性的图像。除了简单的训练和部署(我们没有具体执行调优的任何数据集),EDeiTs实现结果可比性的早些时候仔细调整状态的艺术方法,甚至超越他们在生物多样性分类图像的四个十数据集。gydF4y2Ba

专注于一个数据集,我们比较DeiT与CNN模型(类似的结果源于比较香草vit)。尽管个别CNN和DeiT的类似的性能模型,整体效益DeiTs在更大的程度上。我们将此归因于两种机制。在较小的程度上,信心向量DeiTs不太见顶的最高价值,有轻微的整体效益。主要程度上独立于体系结构中,CNN模型的预测非常相似(独立的预测是错误的或右),而不同DeiTs较低程度的相互协议,这对整体结果是有益的。DeiT学习者之间的更大的独立性也表明,损失的DeiTs景观从本质上不同于cnn,这DeiTs可能是特别适合的算法平均模型在学习权重,如随机加权平均gydF4y2Ba33gydF4y2Ba,因为不同的重量配置似乎解释图像以不同的方式。gydF4y2Ba

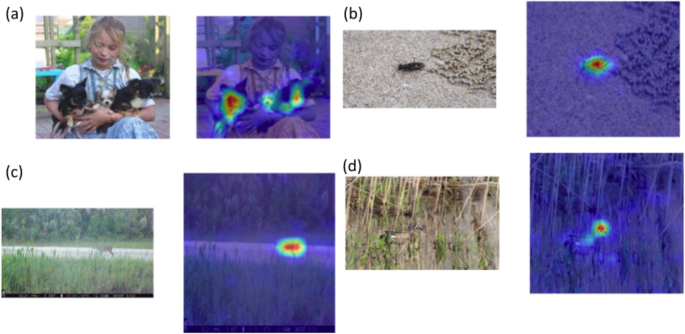

DeiT模型和多种维生素,我们使用有同样数量的参数与cnn相比,和所需的计算能力训练他们是相似的。除了它们的部署要求类似的努力,更高的性能,DeiTs的额外优势被生态学家比cnn直截了当地解释的,因为注意力地图特征的变压器。注意机制允许轻松地识别在图像模型集中其注意力(无花果。gydF4y2Ba3gydF4y2Ba),呈现DeiTs由最终用户更加透明和可控。gydF4y2Ba

所有这些观察姿势EDeiTs坚实的首选方法,生态监测的分类图像。尽管EDeiTs可能同样坚实的方法也在不同的领域,我们不希望EDeiTs打败的状态CIFAR等艺术主流的数据集gydF4y2Ba34gydF4y2Ba或ImageNetgydF4y2Ba35gydF4y2Ba。事实上,对于这样的数据集,巨大的努力都是为了实现艺术的状态,架构根据这些数据集gydF4y2Ba36gydF4y2Ba,他们的培训需要巨大的数值。甚至重用相同的架构,很难实现高单模表演简单的培训协议和温和的计算资源。此外,尽管整体提供好处gydF4y2Ba37gydF4y2Ba剪裁精良,体系结构的选择可以提供相同的好处gydF4y2Ba38gydF4y2Ba。因此,预计SOTA模型训练这些数据集将从整体效益少。gydF4y2Ba

最后,我们注意到机器学习模型的名义测试性能时常常受到降低部署在现实世界的数据模型。这种现象称为gydF4y2Ba数据转移gydF4y2Ba,本质上可以归结为数据集通常不充分代表图像的分布,采样时刻的部署gydF4y2Ba39gydF4y2Ba。这可能是由于各种原因(抽样方法,仪器退化,季节性影响,等等),很难驾驭。然而,最近表明,视觉变压器模型(在这里,维特和DeiT)更健壮的数据转移gydF4y2Ba40gydF4y2Ba,gydF4y2Ba41gydF4y2Ba,gydF4y2Ba42gydF4y2Ba和其他种类的遮挡等干扰gydF4y2Ba41gydF4y2Ba的原因,这是一个进一步部署EDeiTs生态监测。gydF4y2Ba

方法gydF4y2Ba

数据gydF4y2Ba

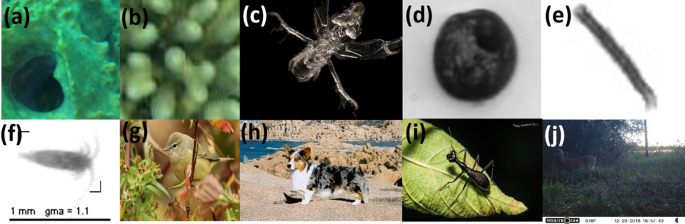

我们测试了我们的模型在十公开的数据集。在无花果。gydF4y2Ba4gydF4y2Ba我们展示的示例图像的每一个数据集。适用时,训练和测试将保持相同的原始数据集。Kaggle,例如,ZooScan埃拉特,和RSMAS数据缺乏特定的训练集和测试集;在这些情况下,基准测试gydF4y2BakgydF4y2Ba倍交叉验证gydF4y2Ba43gydF4y2Ba,gydF4y2Ba44gydF4y2Ba,我们遵循相同的程序,以允许一个公平的比较。gydF4y2Ba

从每个数据集的例子图片。gydF4y2Ba一个gydF4y2Ba)RSMAS (gydF4y2BabgydF4y2Ba)埃拉特(gydF4y2BacgydF4y2Ba)ZooLake (gydF4y2BadgydF4y2Ba)WHOI (gydF4y2BaegydF4y2Ba)Kaggle (gydF4y2BafgydF4y2Ba)ZooScan (gydF4y2BaggydF4y2Ba)NA-Birds (gydF4y2BahgydF4y2Ba斯坦福(狗)gydF4y2Ba我gydF4y2Ba)SriLankan甲虫(gydF4y2BajgydF4y2Ba佛罗里达Wildtrap)。gydF4y2Ba

RSMAS这是一个小珊瑚数据集766 RGB图像补丁的大小gydF4y2Ba256 \ \ 256 \倍)gydF4y2Ba像素每一gydF4y2Ba45gydF4y2Ba。补丁出现了更大的图像获得的迈阿密大学罗森斯蒂尔海洋和大气科学学院的。这些图像捕获使用各种相机在不同的位置。数据分为14组和不平衡的标签对应于珊瑚物种的拉丁名字。这个数据集的当前SOTA分类gydF4y2Ba44gydF4y2Ba。他们使用的整体表现最好11 CNN模型。最好的模型是基于顺序向前特征选择(设定触发器)的方法。因为一个独立的测试不可用,他们利用5倍交叉验证基准测试性能。gydF4y2Ba

埃拉特这是珊瑚数据集1123 64像素的RGB图像补丁gydF4y2Ba45gydF4y2Ba创建从较大的图像,从珊瑚礁埃拉特在红海附近。图像数据集分割成八类,分配不均的数据。类的名称对应的短版的科学名称珊瑚物种。当前SOTAgydF4y2Ba44gydF4y2Ba分类的数据集使用的整体表现最好11 CNN模型类似于RSMAS数据集和5倍交叉验证基准测试性能。gydF4y2Ba

ZooLake湖浮游生物的这个数据集包含17943图像从35类,获得使用Dual-magnification斯克里普斯湖浮游生物的相机(DSPC) Greifensee(瑞士)在2018年和2020年之间gydF4y2Ba14gydF4y2Ba,gydF4y2Ba46gydF4y2Ba。图像是彩色的,一个黑色的背景和一个类分布不均匀。当前SOTAgydF4y2Ba22gydF4y2Ba在这个数据集是基于叠加合奏6 CNN模型在一个独立的测试集。gydF4y2Ba

WHOI这个数据集gydF4y2Ba47gydF4y2Ba包含图片的海洋浮游生物被FlowCytobot形象gydF4y2Ba48gydF4y2Ba,从伍兹霍尔港水。抽样是深秋和早春在2004年和2005年之间。它包含6600灰度级图像的不同尺寸,从22个手动分类浮游生物类为每个类与同等数量的样本。大多数的类属于浮游植物在属的水平上。这个数据集后来扩展到包括3.4图像和103类。WHOI子集,我们使用以前用于基准测试的浮游生物分类模型gydF4y2Ba43gydF4y2Ba,gydF4y2Ba44gydF4y2Ba。当前SOTAgydF4y2Ba22gydF4y2Ba在这个数据集是基于平均乐团6 CNN模型的一个独立的测试集。gydF4y2Ba

Kaggle-plankton原Kaggle-plankton数据集包括浮游生物图像,通过原位Ichthyoplankton成像系统(ISIIS)技术从2014年5月到6月在佛罗里达海峡。数据集出版Kaggle (gydF4y2Bahttps://www.kaggle.com/c/datasciencebowlgydF4y2Ba),图片来自俄勒冈州立大学的哈特菲尔德海洋科学中心。原始Kaggle-plankton数据集的一个子集是发表的gydF4y2Ba43gydF4y2Ba基准浮游生物分类任务。这个子集包含14374灰度级图像从38类,类间的分布不均匀,但每个班级至少有100个样本。当前SOTAgydF4y2Ba22gydF4y2Ba使用平均合奏6 CNN模型和基准使用5倍交叉验证的性能。gydF4y2Ba

ZooScan ZooScan数据集包括3771个灰度级浮游生物图像获得使用ZooScan技术Villefranche-sur-mer海湾gydF4y2Ba49gydF4y2Ba。这个数据集用于基准测试的分类模型在以前的浮游生物识别的论文gydF4y2Ba43gydF4y2Ba,gydF4y2Ba44gydF4y2Ba。数据集由20类变量数量的样本为每一个类从28 - 427。当前SOTAgydF4y2Ba22gydF4y2Ba使用平均合奏6 CNN使用2倍交叉验证模型和基准的性能。gydF4y2Ba

NA-Birds NA-BirdsgydF4y2Ba50gydF4y2Ba是一家集48000标题图片北美的400个最常见鸟类。对于每一个物种,有超过100的图片,对男性不同的注解,女性和青少年,总计555视觉类别。当前SOTAgydF4y2Ba51gydF4y2Ba叫TransFG修改纯维特模型通过添加对比特征学习和选择模块取代了一部分原始输入序列与令牌变压器层对应的区域之间的距离表示困惑子类可以扩大。他们使用一个独立的测试基准模型的表现。gydF4y2Ba

斯坦福斯坦福狗狗数据集包含20580彩色图像的120个不同的来自全球各地的犬种,分为12000 8580训练图像和测试图像gydF4y2Ba52gydF4y2Ba。当前SOTAgydF4y2Ba51gydF4y2Ba利用修改维特模型在NA-Birds数据集称为TransFG如上所述。他们使用一个独立的测试基准模型的表现。gydF4y2Ba

斯里兰卡的甲虫的虎甲虫数据gydF4y2Ba53gydF4y2Ba包括380个图像拍摄于2017年8月至2020年9月从22个地方在斯里兰卡,包括所有气候区和省份,以及14区。gydF4y2BaTricondylagydF4y2Ba(3种),gydF4y2BaDerocraniagydF4y2Ba(5种),gydF4y2BaNeocollyrisgydF4y2Ba(1种)等九种发现,其中六个被流行。当前SOTAgydF4y2Ba53gydF4y2Ba利用CNN-based SqueezeNet架构和被训练使用pre-trained ImageNet的权重。模型的基准性能是一个独立的测试集。gydF4y2Ba

佛罗里达野生捕捉野生动物相机陷阱gydF4y2Ba54gydF4y2Ba分类数据集包含104495个图像与视觉相似的物种,不同的照明条件下,倾斜类分布和濒危物种的样本,如佛罗里达美洲豹。这是来自佛罗里达州西南部两个地点。这些图像分类在22类。当前SOTAgydF4y2Ba54gydF4y2Ba利用CNN-based ResNet-50架构和模型的性能基准测试在一个独立的测试集。gydF4y2Ba

模型gydF4y2Ba

视觉变形金刚(vit)gydF4y2Ba31日gydF4y2Ba是一个适应计算机视觉的变形金刚,最初是为自然语言处理开发gydF4y2Ba30.gydF4y2Ba。他们的特点是,而不是利用平移对称,cnn一样,他们有一个gydF4y2Ba注意机制gydF4y2Ba确定最相关的部分图像。维特最近表现cnn在图像分类任务,大量的训练数据和处理资源是可用的gydF4y2Ba30.gydF4y2Ba,gydF4y2Ba55gydF4y2Ba。然而,对于绝大多数的用例和消费者,数据和/或计算资源限制,维特本质上是untrainable,即使网络体系结构的定义和体系结构优化是必需的。为了解决这个问题,Data-efficient图像变形金刚(DeiTs)提出了gydF4y2Ba32gydF4y2Ba。这些变压器模型设计与更少的训练数据和计算资源少得多gydF4y2Ba32gydF4y2Ba。在DeiTs,变压器结构已经修改为允许本地蒸馏gydF4y2Ba56gydF4y2Ba神经网络中,一个学生可以从老师的结果模型。这里,CNN作为教师模型,纯视觉变压器作为学生网络。所有的DeiT模型我们报告以下DeiT-Base模型gydF4y2Ba32gydF4y2Ba。维特是ViT-B16、ViT-B32 ViT-L32模型gydF4y2Ba31日gydF4y2Ba。gydF4y2Ba

实现gydF4y2Ba

训练我们的模型,我们使用转移学习gydF4y2Ba57gydF4y2Ba:我们花了一个模型,已经pre-trained ImageNetgydF4y2Ba35gydF4y2Ba数据集,改变了最后一层根据类的数量,然后调整整个网络学习速率很低。所有的模型都是训练和两个Nvidia GTX 2080 ti gpu。gydF4y2Ba

我们使用DeiTs DeiT-BasegydF4y2Ba32gydF4y2Ba蒂姆的架构,使用Python包gydF4y2Ba58gydF4y2Ba,其中包括许多著名的深度学习架构,连同他们的pre-trained ImageNet数据集的权重计算gydF4y2Ba35gydF4y2Ba。我们调整输入图像224 x 224像素,然后,防止模型过度拟合在像素级和帮助其推广更好,我们采用典型图像对应等在训练水平和垂直翻转,旋转180度,小放大到20%,一个小高斯模糊,剪切高达10%。处理类不平衡,我们使用类权重调整错误每个示例的礼物类数据集gydF4y2Ba59gydF4y2Ba。我们使用sklearn公用事业gydF4y2Ba60gydF4y2Ba计算类权重,我们在训练阶段。gydF4y2Ba

开始一个默认pytorch训练阶段gydF4y2Ba61年gydF4y2Ba初始条件(房型统一初始化),一个AdamW与余弦退火优化器gydF4y2Ba62年gydF4y2Ba,基础学习的速度gydF4y2Ba\ (10 ^ {4}\)gydF4y2Ba权重衰减值为0.03,批量大小的32和监督使用叉损失。我们训练有素的早期停止,中断培训如果验证F1-score不提高5时代。然后学习速率下降了10倍。我们迭代,直到学习速率达到最终的价值gydF4y2Ba\ (10 ^ {6}\)gydF4y2Ba。这个过程相当于大约100时代,独立的数据集。培训时间取决于数据集的大小。它介于20分钟之间(SriLankan甲虫)9 h(佛罗里达Wildtrap)。我们使用相同的程序为所有数据集:没有额外的时间需要hyperparameter调优。gydF4y2Ba

维特我们实现ViT-B16 ViT-B32和ViT-L32模型使用Python包vit-keras (gydF4y2Bahttps://github.com/faustomorales/vit-kerasgydF4y2Ba),包括从ImageNet pre-trained权重计算gydF4y2Ba35gydF4y2Ba数据集和Tensorflow图书馆gydF4y2Ba63年gydF4y2Ba。gydF4y2Ba

首先,我们调整输入图像128×128和雇佣等典型形象对应在训练水平和垂直翻转,旋转180度,小20%缩放,小高斯模糊,剪切高达10%。处理类不平衡,我们计算了类重量和使用他们在训练阶段。gydF4y2Ba

使用转移学习,我们进口pre-trained模型和冻结所有的层来训练模型。我们删除了最后一层,取而代之我们添加了一个致密层gydF4y2Ba\ (n_c \)gydF4y2Ba输出(被gydF4y2Ba\ (n_c \)gydF4y2Ba类的数量),是之前和之后辍学层。我们使用了Keras-tunergydF4y2Ba64年gydF4y2Ba与贝叶斯优化搜索gydF4y2Ba65年gydF4y2Ba确定最佳的hyperparameters集,其中包括辍学率,学习速率和致密层参数(10试验和100时代)。之后,最好的模型hyperparameters与默认tensorflow训练gydF4y2Ba63年gydF4y2Ba初始条件(Glorot统一初始化器)使用早期停止150年时代,涉及停止训练后如果没有验证损失减少50时代和保留验证最低损失的模型参数。gydF4y2Ba

美国有线电视新闻网cnn包括DenseNetgydF4y2Ba66年gydF4y2Ba,MobileNetgydF4y2Ba67年gydF4y2Ba,EfficientNet-B2gydF4y2Ba68年gydF4y2Ba,EfficientNet-B5gydF4y2Ba68年gydF4y2Ba,EfficientNet-B6gydF4y2Ba68年gydF4y2Ba,EfficientNet-B7gydF4y2Ba68年gydF4y2Ba架构。我们跟着训练过程中描述Ref。gydF4y2Ba22gydF4y2Batensorflow,进行培训。gydF4y2Ba

整体学习gydF4y2Ba

我们采用平均合奏,它需要不同的学习者的信心向量,并产生一个预测基于信心之间的平均向量。这个过程,所有个体模型同样有助于最终的预测,无论他们验证性能。合奏通常会导致优越的整体分类指标和模型的鲁棒性gydF4y2Ba69年gydF4y2Ba,gydF4y2Ba70年gydF4y2Ba。gydF4y2Ba

给定一组的gydF4y2BangydF4y2Ba与预测模型、向量gydF4y2Ba\ (vec为c_i ~ \ (i = 1 \ ldots n) \)gydF4y2Ba,这些通常是通过算术平均聚合。组件的整体信心向量gydF4y2Ba\ vec c_ (\ {AA} \)gydF4y2Ba,与每一个类gydF4y2Ba\α(\ \)gydF4y2Ba然后gydF4y2Ba

另一个选择是使用几何平均,gydF4y2Ba

我们可以正常的向量gydF4y2Bavec c_g \ (\ \)gydF4y2Ba,但这是不相关的,因为我们感兴趣的是其最大的组件,gydF4y2Ba\ (max _ \ displaystyle \ \α(c_ {GA \α})\)gydF4y2Ba,标准化以同样的方式影响所有组件。事实上,也gydF4y2BangydF4y2Bath根本不会改变的相对大小的组件,而不是gydF4y2Ba\ vec c_ (\ {GA} \)gydF4y2Ba我们可以用一个产品规则:gydF4y2Ba\ (max _ \ displaystyle \ \α(c_ {GA \α})= max _ \ \α(c_{刺激\α})\)gydF4y2Ba,gydF4y2Ba\ (\ displaystyle c_{刺激\α}= \ PROD _ {i = 1} ^ n c_α}{我\ \)gydF4y2Ba。gydF4y2Ba

虽然这两种平均等效的两个模型两类,它们通常是不同的在其他任何情况下gydF4y2Ba71年gydF4y2Ba。例如,它可以很容易地看到,几何平均惩罚更强烈的类至少一个学习者信心很低价值,称为属性gydF4y2Ba否决gydF4y2Ba机制gydF4y2Ba72年gydF4y2Ba(注意,在裁判。gydF4y2Ba72年gydF4y2Ba这个词gydF4y2Ba否决gydF4y2Ba时使用的信心值是零,这里我们使用这个术语在一个稍微宽松的方式)。gydF4y2Ba

数据可用性gydF4y2Ba

我们使用的所有数据是开放的。数据集分析在当前研究中可用存储库,我们表明在“gydF4y2Ba数据gydF4y2Ba”一节。gydF4y2Ba

代码的可用性gydF4y2Ba

的代码复制我们的结果是可用的gydF4y2Bahttps://github.com/kspruthviraj/PlankiformergydF4y2Ba。gydF4y2Ba

改变历史gydF4y2Ba

2023年4月17日gydF4y2Ba

这篇论文已经发表的校正:gydF4y2Bahttps://doi.org/10.1038/s41598 - 023 - 32258 - 4gydF4y2Ba

引用gydF4y2Ba

Kremen C。,Merenlender, A. M. & Murphy, D. D. Ecological monitoring: A vital need for integrated conservation and development programs in the tropics.Conserv。医学杂志。gydF4y2Ba8gydF4y2Ba,388 - 397 (1994)。gydF4y2Ba

Jetz, W。gydF4y2Baet al。gydF4y2Ba至关重要的生物多样性变量映射和监测物种种群。gydF4y2BaNat,生态。另一个星球。gydF4y2Ba3gydF4y2Ba,539 - 551 (2019)。gydF4y2Ba

库尔,h·S。gydF4y2Baet al。gydF4y2Ba有效的生物多样性监测需求的文化整合。gydF4y2Ba一个地球gydF4y2Ba3gydF4y2Ba,462 - 474。gydF4y2Bahttps://doi.org/10.1016/j.oneear.2020.09.010gydF4y2Ba(2020)。gydF4y2Ba

威默,g .野生动物人口监测:一些实际问题。gydF4y2BaWildl。Res。gydF4y2Bahttps://doi.org/10.1071/WR04003gydF4y2Ba(2005)。gydF4y2Ba

McEvoy, j·F。,Hall, G. P. & McDonald, P. G. Evaluation of unmanned aerial vehicle shape, flight path and camera type for waterfowl surveys: Disturbance effects and species recognition.同行J。gydF4y2Ba4gydF4y2Ba,e1831-e1831。gydF4y2Bahttps://doi.org/10.7717/peerj.1831gydF4y2Ba(2016)。gydF4y2Ba

霍奇森,j . C。gydF4y2Baet al。gydF4y2Ba无人机野生动物比人类更准确和精确计数。gydF4y2Ba生态方法。另一个星球。gydF4y2Ba9gydF4y2Ba,1160 - 1167。gydF4y2Bahttps://doi.org/10.1111/2041 - 210 x.12974gydF4y2Ba(2018)。gydF4y2Ba

Tuia D。gydF4y2Baet al。gydF4y2Ba角度为野生动物保护机器学习。gydF4y2BaCommun Nat。gydF4y2Ba13gydF4y2Ba,792年。gydF4y2Bahttps://doi.org/10.1038/s41467 - 022 - 27980 - ygydF4y2Ba(2022)。gydF4y2Ba

Soranno, p。gydF4y2Baet al。gydF4y2BaCross-scale交互:量化多尺度宏观系统的因果关系。gydF4y2Ba前面。生态。环绕。gydF4y2Ba12gydF4y2Ba,65 - 73。gydF4y2Bahttps://doi.org/10.1890/120366gydF4y2Ba(2014)。gydF4y2Ba

里克,S。,Pettorelli, N., Vihervaara, P. & Wegmann, M. Improving biodiversity monitoring using satellite remote sensing to provide solutions towards the 2020 conservation targets.生态方法。另一个星球。gydF4y2Ba9gydF4y2Ba,1784 - 1786。gydF4y2Bahttps://doi.org/10.1111/2041 - 210 x.13057gydF4y2Ba(2018)。gydF4y2Ba

伯顿,a . C。gydF4y2Baet al。gydF4y2Ba点评:野生动物相机陷阱:一个回顾和调查与生态过程的建议。gydF4y2Baj:。生态。gydF4y2Ba52gydF4y2Ba,675 - 685。gydF4y2Bahttps://doi.org/10.1111/1365 - 2664.12432gydF4y2Ba(2015)。gydF4y2Ba

Rowcliffe, j . m . &痈,c .调查使用相机陷阱:我们期待一个更光明的未来吗?gydF4y2Ba动画。Conserv。gydF4y2Ba11gydF4y2Ba,185 - 186。gydF4y2Bahttps://doi.org/10.1111/j.1469-1795.2008.00180.xgydF4y2Ba(2008)。gydF4y2Ba

Steenweg, R。gydF4y2Baet al。gydF4y2Ba扩大相机陷阱:监测地球的生物多样性和网络的远程传感器。gydF4y2Ba前面。生态。环绕。gydF4y2Ba15gydF4y2Ba,保险。gydF4y2Bahttps://doi.org/10.1002/fee.1448gydF4y2Ba(2017)。gydF4y2Ba

奥仁斯坦,e . C。gydF4y2Baet al。gydF4y2Ba斯克里普斯浮游生物摄像系统:一个框架和原位显微镜平台。gydF4y2BaLimnol。Oceanogr。方法gydF4y2Ba18gydF4y2Ba,681 - 695。gydF4y2Bahttps://doi.org/10.1002/lom3.10394gydF4y2Ba(2020)。gydF4y2Ba

梅尔兹,E。gydF4y2Baet al。gydF4y2Ba水下dual-magnification成像自动湖浮游生物监测。gydF4y2Ba水Res。gydF4y2Ba203年gydF4y2Ba,117524年。gydF4y2Bahttps://doi.org/10.1101/2021.04.14.439767gydF4y2Ba(2021)。gydF4y2Ba

法利,美国年代。道森,。,Goring, S. J. & Williams, J. W. Situating ecology as a big-data science: Current advances, challenges, and solutions.生物科学gydF4y2Ba68年gydF4y2Ba,563 - 576。gydF4y2Bahttps://doi.org/10.1093/biosci/biy068gydF4y2Ba(2018)。gydF4y2Ba

贾米森,大肠& Gurevych,即噪声或其他信息吗?利用外包注释项协议自然语言任务。在gydF4y2Ba学报2015年大会在自然语言处理的经验方法gydF4y2Ba291 - 297页(2015)。gydF4y2Ba

郭,r . Ai授权保护生物学。gydF4y2Ba自然gydF4y2Ba567年gydF4y2Ba,133 - 134。gydF4y2Bahttps://doi.org/10.1038/d41586 - 019 - 00746 - 1gydF4y2Ba(2019)。gydF4y2Ba

Norouzzadeh, m . S。gydF4y2Baet al。gydF4y2Ba自动识别、计算和描述野生动物在特征图像与深度学习。gydF4y2BaProc。国家的。学会科学。gydF4y2Ba115年gydF4y2Ba,E5716-E5725。gydF4y2Bahttps://doi.org/10.1073/pnas.1719367115gydF4y2Ba(2018)。gydF4y2Ba

威利,M。gydF4y2Baet al。gydF4y2Ba识别动物式相机图像中使用深度学习和公民科学。gydF4y2Ba生态方法。另一个星球。gydF4y2Ba10gydF4y2Ba,80 - 91。gydF4y2Bahttps://doi.org/10.1111/2041 - 210 x.13099gydF4y2Ba(2019)。gydF4y2Ba

Tabak, m·A。gydF4y2Baet al。gydF4y2Ba机器学习分类相机陷阱的动物图片:在生态学中的应用。gydF4y2Ba生态方法。另一个星球。gydF4y2Ba10gydF4y2Ba,585 - 590。gydF4y2Bahttps://doi.org/10.1111/2041 - 210 x.13120gydF4y2Ba(2019)。gydF4y2Ba

亨利克先生,d . W。、角度、S。,Gaonkar, C. C. & Campbell, L. Application of a convolutional neural network to improve automated early warning of harmful algal blooms.环绕。科学。Pollut。Res。gydF4y2Ba页1 - 12 (2021)。gydF4y2Ba

Kyathanahally, s P。gydF4y2Baet al。gydF4y2Ba深湖浮游动物的分类学习。gydF4y2Ba前面。Microbiol。gydF4y2Bahttps://doi.org/10.3389/fmicb.2021.746297gydF4y2Ba(2021)。gydF4y2Ba

Py, O。,Hong, H., & Zhongzhi, S. Plankton classification with deep convolutional neural networks. In2016年IEEE信息技术、网络、电子和自动化控制会议gydF4y2Ba页132 - 136。gydF4y2Bahttps://doi.org/10.1109/ITNEC.2016.7560334gydF4y2Ba(2016)。gydF4y2Ba

戴,J。,Yu, Z., Zheng, H., Zheng, B. & Wang, N. A hybrid convolutional neural network for plankton classification. In Chen, C.-S., Lu, J. & Ma, K.-K. (eds.) Computer Vision – ACCV 2016 Workshops, 102–114 (Springer International Publishing, Cham, 2017).

李,H。,Park, M. & Kim, J. Plankton classification on imbalanced large scale database via convolutional neural networks with transfer learning. In2016年IEEE国际会议上图像处理(ICIP)gydF4y2Ba,页3713 - 3717。gydF4y2Bahttps://doi.org/10.1109/ICIP.2016.7533053gydF4y2Ba(2016)。gydF4y2Ba

罗,j . Y。gydF4y2Baet al。gydF4y2Ba使用卷积神经网络自动浮游生物图像分析。gydF4y2BaLimnol。Oceanogr。方法gydF4y2Ba16gydF4y2Ba,814 - 827。gydF4y2Bahttps://doi.org/10.1002/lom3.10285gydF4y2Ba(2018)。gydF4y2Ba

伊斯兰教,美国b &水手,d .野生物种的识别在德克萨斯州保护使用深层神经网络从特征图像监控。在gydF4y2Ba2020年第十届计算和通信研讨会和会议(CCWC)gydF4y2Ba页0537 - 0542,gydF4y2Bahttps://doi.org/10.1109/CCWC47524.2020.9031190gydF4y2Ba(2020)。gydF4y2Ba

绿色,s E。,Rees, J. P., Stephens, P. A., Hill, R. A. & Giordano, A. J. Innovations in camera trapping technology and approaches: The integration of citizen science and artificial intelligence.动物gydF4y2Bahttps://doi.org/10.3390/ani10010132gydF4y2Ba(2020)。gydF4y2Ba

施耐德,S。,Greenberg, S., Taylor, G. W. & Kremer, S. C. Three critical factors affecting automated image species recognition performance for camera traps.生态。另一个星球。gydF4y2Ba10gydF4y2Ba,3503 - 3517。gydF4y2Bahttps://doi.org/10.1002/ece3.6147gydF4y2Ba(2020)。gydF4y2Ba

Vaswani, et al。注意是你所需要的。相关系数gydF4y2BaarXiv: 1706.03762gydF4y2Ba(2017)。gydF4y2Ba

Dosovitskiy, a . et al .图像值得16 x16词:变形金刚的大规模图像识别。相关系数gydF4y2BaarXiv: 2010.11929gydF4y2Ba(2020)。gydF4y2Ba

Touvron, h . et al .培训data-efficient图像变形金刚和蒸馏通过关注。相关系数gydF4y2BaarXiv: 2012.12877gydF4y2Ba(2020)。gydF4y2Ba

Izmailov, P。,Podoprikhin, D., Garipov, T., Vetrov, D. & Wilson, A. G. Averaging weights leads to wider optima and better generalization (2018).

Krizhevsky, a .学习多层特性的小图片。(2009)。gydF4y2Bahttps://www.cs.toronto.edu/ kriz /学习- - 2009 tr.pdf特性gydF4y2Ba。gydF4y2Ba

邓,j . et al . Imagenet:大规模的分层图像数据库。在gydF4y2Ba2009年IEEE计算机视觉与模式识别会议gydF4y2Ba248 - 255页(Ieee 2009)。gydF4y2Ba

B·雷希特。,Roelofs, R., Schmidt, L. & Shankar, V. Do imagenet classifiers generalize to imagenet?. In国际会议上机器学习gydF4y2Ba5389 - 5400页(PMLR, 2019)。gydF4y2Ba

d 'Ascoli,年代。,Refinetti, M., Biroli, G. & Krzakala, F. Double trouble in double descent: Bias and variance (s) in the lazy regime. In国际会议上机器学习gydF4y2Ba2280 - 2290页(PMLR, 2020)。gydF4y2Ba

Nakkiran, P。Venkat, P。,Kakade, S. & Ma, T. Optimal regularization can mitigate double descent. arXiv preprintarXiv: 2003.01897gydF4y2Ba(2020)。gydF4y2Ba

Moreno-Torres, j·G。雷德尔,T。,Alaiz-Rodríguez, R., Chawla, N. V. & Herrera, F. A unifying view on dataset shift in classification.Recogn模式。gydF4y2Ba45gydF4y2Ba,521 - 530。gydF4y2Bahttps://doi.org/10.1016/j.patcog.2011.06.019gydF4y2Ba(2012)。gydF4y2Ba

看守者,M。gydF4y2Baet al。gydF4y2Ba现代神经网络的重新校准。gydF4y2Ba放置的神经。正无穷。过程。系统。gydF4y2Ba34gydF4y2Ba,15682 - 15694 (2021)。gydF4y2Ba

Naseer, M . M。gydF4y2Baet al。gydF4y2Ba有趣的视觉变形金刚的属性。gydF4y2Ba放置的神经。正无穷。过程。系统。gydF4y2Ba34gydF4y2Ba,23296 - 23308 (2021)。gydF4y2Ba

保罗,s &陈P.-Y。视觉变形金刚是健壮的学习者。在gydF4y2Ba人工智能学报AAAI会议gydF4y2Ba36gydF4y2Ba,2071 - 2081页(2022)。gydF4y2Ba

郑,H。gydF4y2Baet al。gydF4y2Ba自动浮游生物图像分类结合多个视图功能通过多个内核的学习。gydF4y2BaBMC Bioinf。gydF4y2Ba18gydF4y2Ba,570年。gydF4y2Bahttps://doi.org/10.1186/s12859 - 017 - 1954 - 8gydF4y2Ba(2017)。gydF4y2Ba

Lumini,。,Nanni, L. & Maguolo, G. Deep learning for plankton and coral classification.达成。第一版。通知。gydF4y2Bahttps://doi.org/10.1016/j.aci.2019.11.004gydF4y2Ba(2020)。gydF4y2Ba

Gomez-Rios,。gydF4y2Baet al。gydF4y2Ba对高精度珊瑚纹理图像分类使用深卷积神经网络和数据增大。gydF4y2Ba专家系统。达成。gydF4y2Ba118年gydF4y2Ba,315 - 328。gydF4y2Bahttps://doi.org/10.1016/j.eswa.2018.10.010gydF4y2Ba(2019)。gydF4y2Ba

Kyathanahally, S。gydF4y2Baet al。gydF4y2Ba数据:深度学习湖浮游动物的分类。gydF4y2Ba前面。Microbiol。gydF4y2Bahttps://doi.org/10.25678/0004DYgydF4y2Ba(2021)。gydF4y2Ba

Sosik, h &奥尔森,r .自动分类的浮游植物分类抽样与imaging-in-flow血细胞计数。gydF4y2BaLimnol。Oceanogr。方法gydF4y2Ba5gydF4y2Ba,204 - 216 (2007)。gydF4y2Ba

奥尔森r . j . & Sosik h . m .潜水imaging-in-flow仪器分析纳米与microplankton:成像flowcytobot。gydF4y2BaLimnol。Oceanogr。方法gydF4y2Ba5gydF4y2Ba,195 - 203。gydF4y2Bahttps://doi.org/10.4319/lom.2007.5.195gydF4y2Ba(2007)。gydF4y2Ba

Gorsky G。gydF4y2Baet al。gydF4y2Ba数字使用ZooScan浮游动物图像分析集成系统。gydF4y2Baj .浮游生物Res。gydF4y2Ba32gydF4y2Ba,285 - 303。gydF4y2Bahttps://doi.org/10.1093/plankt/fbp124gydF4y2Ba(2010)。gydF4y2Ba

范霍恩,g . et al。建立一个鸟类识别应用和大规模数据集与公民科学家:细粒度数据集收集的小字。在gydF4y2Ba2015年IEEE计算机视觉与模式识别会议(CVPR)gydF4y2Ba。页595 - 604。gydF4y2Bahttps://doi.org/10.1109/CVPR.2015.7298658gydF4y2Ba(2015)。gydF4y2Ba

他,J。gydF4y2Ba等gydF4y2Ba。Transfg:变压器结构细粒度的识别。相关系数gydF4y2BaarXiv: 2103.07976gydF4y2Ba(2021)。gydF4y2Ba

科斯拉,。,Jayadevaprakash, N., Yao, B. & Fei-Fei, L. Novel dataset for fine-grained image categorization. In第一次研讨会细粒度的视觉分类,IEEE计算机视觉与模式识别会议gydF4y2Ba(科罗拉多斯普林斯,有限公司,2011年)。gydF4y2Ba

Abeywardhana D。Dangalle C。,Nugaliyadde, A. & Mallawarachchi, Y. Deep learning approach to classify tiger beetles of Sri Lanka.生态。通知。gydF4y2Ba62年gydF4y2Ba,101286年。gydF4y2Bahttps://doi.org/10.1016/j.ecoinf.2021.101286gydF4y2Ba(2021)。gydF4y2Ba

赢,C。,Kini, J., Smith, D. & Shah, M. Florida wildlife camera trap dataset. CoRRarXiv: 2106.12628gydF4y2Ba(2021)。gydF4y2Ba

徐,Y。,Zhang, Q., Zhang, J. & Tao, D. Vitae: Vision transformer advanced by exploring intrinsic inductive bias. CoRRarXiv: 2106.03348gydF4y2Ba(2021)。gydF4y2Ba

Allen-Zhu、z和李,y向理解合奏,蒸馏和self-distillation深陷学习知识。相关系数gydF4y2BaarXiv: 2012.09816gydF4y2Ba(2020)。gydF4y2Ba

棕褐色,c . et al .调查深转移学习。在gydF4y2Ba国际会议上人工神经网络gydF4y2Ba270 - 279页(Springer, 2018)。gydF4y2Ba

火炬图像模型(2022)。可以在gydF4y2Bahttps://fastai.github.io/timmdocs/gydF4y2Ba。gydF4y2Ba

约翰逊,j . m . & Khoshgoftaar t . m .调查深度学习与类不平衡。gydF4y2Baj .大数据gydF4y2Ba6gydF4y2Ba1-54 (2019)。gydF4y2Ba

Pedregosa F。gydF4y2Baet al。gydF4y2Ba在Python Scikit-learn:机器学习。gydF4y2Baj·马赫。学习。Res。gydF4y2Ba12gydF4y2Ba,2825 - 2830 (2011)。gydF4y2Ba

Paszke,。gydF4y2Baet al。gydF4y2BaPytorch:命令式风格、高性能深度学习的图书馆。gydF4y2Ba放置神经Inf。过程。系统。gydF4y2Ba32gydF4y2Ba,8024 - 8035 (2019)。gydF4y2Ba

Loshchilov i & Hutter f .修复体重衰变正规化亚当。相关系数gydF4y2Baabs / 1711.05101gydF4y2Ba(2017)。gydF4y2Ba

Abadi m . et al . Tensorflow:大规模机器学习在异构分布式系统。相关系数gydF4y2Baabs / 1603.04467gydF4y2Ba(2016)。gydF4y2Ba

奥马利,t . et al . Keras调谐器。gydF4y2Bahttps://github.com/keras-team/keras-tunergydF4y2Ba(2019)。gydF4y2Ba

莫卡斯,J。gydF4y2Ba贝叶斯的全局优化方法:理论和应用程序gydF4y2Ba37卷(施普林格科学与商业媒体,2012)。gydF4y2Ba

黄G。刘,Z。,van der Maaten, L. & Weinberger, K. Q. Densely connected convolutional networks (2018).

桑德勒,M。,Howard, A., Zhu, M., Zhmoginov, A., & Chen, L.-C. Mobilenetv2: Inverted residuals and linear bottlenecks. In2018年IEEE / CVF计算机视觉与模式识别会议gydF4y2Ba。页4510 - 4520。gydF4y2Bahttps://doi.org/10.1109/CVPR.2018.00474gydF4y2Ba(2018)。gydF4y2Ba

褐色,m &勒,问:Efficientnet:反思模型扩展为卷积神经网络。在gydF4y2Ba国际会议上机器学习gydF4y2Ba6105 - 6114页(PMLR, 2019)。gydF4y2Ba

Seni, g . &, J。gydF4y2Ba整体数据挖掘方法:通过结合提高精度的预测gydF4y2Ba2卷(摩根& Claypool出版社,2010)。gydF4y2Ba

张,c .马& Y。gydF4y2Ba整体机器学习:方法和应用gydF4y2Ba(Springer, 2012)。gydF4y2Ba

亚历山大,洛杉矶。,Campilho, A. C. & Kamel, M. On combining classifiers using sum and product rules.Recogn模式。列托人。gydF4y2Ba22gydF4y2Ba,1283 - 1289 (2001)。gydF4y2Ba

税,d . M。,Duin, R. P. & Breukelen, M. V. Comparison between product and mean classifier combination rules. In In Proc. Workshop on Statistical Pattern Recognition, 165–170 (1997).

确认gydF4y2Ba

这个项目由Eawag DF项目大数据工作流(# 5221.00492.999.01),瑞士联邦环境办公室(合同Nr q392 - 1149)和瑞士国家科学基金会(182124项目)。gydF4y2Ba

作者信息gydF4y2Ba

作者和联系gydF4y2Ba

贡献gydF4y2Ba

M.B.J.设计研究”栏目开采数据,”栏目建立了模型,”栏目,T.H.,。,结核,核磁共振,回堵,F.P. and M.B.J. were actively involved in the discussion while building and improving the models and data, S.K. and M.B.J. wrote the paper. All the authors contributed to the manuscript.

相应的作者gydF4y2Ba

道德声明gydF4y2Ba

相互竞争的利益gydF4y2Ba

作者宣称没有利益冲突。gydF4y2Ba

额外的信息gydF4y2Ba

出版商的注意gydF4y2Ba

施普林格自然保持中立在发表关于司法主权地图和所属机构。gydF4y2Ba

最初的这篇文章的在线版本修订:本文的原始版本包含错误,Data-efficient图像变形金刚的集合体(EDeiTs)性能低于。完整信息的修正可以在本文的修正。gydF4y2Ba

补充信息gydF4y2Ba

权利和权限gydF4y2Ba

开放获取gydF4y2Ba本文是基于知识共享署名4.0国际许可,允许使用、共享、适应、分布和繁殖在任何媒介或格式,只要你给予适当的信贷原始作者(年代)和来源,提供一个链接到创作共用许可证,并指出如果变化。本文中的图片或其他第三方材料都包含在本文的创作共用许可证,除非另有说明在一个信用额度的材料。如果材料不包括在本文的创作共用许可证和用途是不允许按法定规定或超过允许的使用,您将需要获得直接从版权所有者的许可。查看本许可证的副本,访问gydF4y2Bahttp://creativecommons.org/licenses/by/4.0/gydF4y2Ba。gydF4y2Ba

关于这篇文章gydF4y2Ba

引用这篇文章gydF4y2Ba

Kyathanahally,……Hardeman, T。雷耶斯,M。gydF4y2Baet al。gydF4y2Ba乐团data-efficient视觉变形金刚在生态学作为自动分类的新范式。gydF4y2BaSci代表gydF4y2Ba12gydF4y2Ba18590 (2022)。https://doi.org/10.1038/s41598 - 022 - 21910 - 0gydF4y2Ba

收到了gydF4y2Ba:gydF4y2Ba

接受gydF4y2Ba:gydF4y2Ba

发表gydF4y2Ba:gydF4y2Ba

DOIgydF4y2Ba:gydF4y2Bahttps://doi.org/10.1038/s41598 - 022 - 21910 - 0gydF4y2Ba

评论gydF4y2Ba

通过提交评论你同意遵守我们的gydF4y2Ba条款gydF4y2Ba和gydF4y2Ba社区指导原则gydF4y2Ba。如果你发现一些滥用或不符合我们的条件或准则请国旗是不合适的。gydF4y2Ba