摘要gydF4y2Ba

氧化石墨烯(GO)在许多技术中发挥着越来越重要的作用。然而,如何战略性地分配功能组以进一步提高性能仍然没有答案。我们利用深度强化学习(RL)来设计机械强度高的go。将设计任务制定为一个顺序决策过程,并采用策略梯度RL模型最大化GO的韧性。结果表明,我们的方法可以稳定地生成韧性值超过随机go平均值两个标准差的官能团分布。此外,我们的RL方法仅在5000次部署中实现了优化的功能组分布,而最简单的设计任务需要2 × 10gydF4y2Ba11gydF4y2Ba的可能性。最后,我们证明了我们的方法在官能团密度和氧化石墨烯大小方面是可扩展的。本研究展示了官能团分布对氧化石墨烯性质的影响,并说明了深度强化学习方法的有效性和数据效率。gydF4y2Ba

介绍gydF4y2Ba

石墨烯是一种单层碳同素异形体,自发现以来一直被视为材料科学研究的基石gydF4y2Ba1gydF4y2Ba。因此,在科学和工程应用的计算和实验工作中,有几个与石墨烯相关的研究方向gydF4y2Ba2gydF4y2Ba,gydF4y2Ba3.gydF4y2Ba,gydF4y2Ba4gydF4y2Ba,gydF4y2Ba5gydF4y2Ba。氧化石墨烯(GO)是最著名的石墨烯衍生物之一,它继承了石墨烯的许多独特而精致的特性,在电子、储能和生物医学等各个研究领域发挥着越来越重要的作用gydF4y2Ba6gydF4y2Ba,gydF4y2Ba7gydF4y2Ba,gydF4y2Ba8gydF4y2Ba,gydF4y2Ba9gydF4y2Ba,gydF4y2Ba10gydF4y2Ba,gydF4y2Ba11gydF4y2Ba,gydF4y2Ba12gydF4y2Ba。在结构上,氧化石墨烯由石墨烯基面(GBP)和各种含氧官能团组成,包括羟基(C - oh)、环氧化物(C - O - C)、羰基(C=O)和羧基(O=C - oh)基团。在这些官能团中,羟基和环氧化物基团数量较多,分布在GBP的表面,羰基和羧基数量较少,只附着在GBP的边缘gydF4y2Ba13gydF4y2Ba。因此,羟基和环氧化物基团的总量和相对比例决定了氧化石墨烯的化学组成,这对氧化石墨烯的力学性能起着核心作用gydF4y2Ba14gydF4y2Ba。相反,羰基和羧基对氧化石墨烯的化学和力学性能的影响不显著。gydF4y2Ba

然而,仅从氧化石墨烯的化学成分不能准确推断氧化石墨烯的力学性能。给定一种特定的化学成分,由于GBP上官能团空间分布的可变性,氧化石墨烯可以表现出一系列的机械性能。研究表明,官能团的分布会影响氧化石墨烯的塑性和延性等性能,这是由于官能团之间的机械化学相互作用gydF4y2Ba15gydF4y2Ba。我们感兴趣的一个力学特性是韧性,定义为材料在破裂前每单位体积所能吸收的能量。它量化了材料吸收能量和塑性变形而不破裂的能力,因此需要强度和延性的平衡。人们非常需要高韧性的氧化石墨烯,这可以潜在地提高许多基于氧化石墨烯的应用的性能,如纳米复合材料、柔性电子产品等。gydF4y2Ba

给定特定的化学成分,如氧碳比和官能团的相对浓度,我们的目标是通过改变官能团的空间分布来最大限度地提高氧化石墨烯的韧性。现有文献没有充分解决这一问题,并假设官能团分布的影响是次要的。从优化的角度来看,这是一项具有挑战性的任务,存在以下困难:首先,对功能群分布的优化实质上是一个组合优化问题,特别是当问题维数较大时,该问题可能具有np困难和解析难解性。其次,这个问题涉及到复杂的功能群体的相互作用,这些相互作用会随着时间的推移而演变。在开始的时候,对于官能团应该放在哪里,以使GO长期受益,人们几乎没有什么直觉。第三,GO模拟和实验都很昂贵。因此,一个有效的、数据高效的优化策略是非常重要的。gydF4y2Ba

最近,机器学习算法已经成功地应用于材料预测、设计和优化问题gydF4y2Ba16gydF4y2Ba,gydF4y2Ba17gydF4y2Ba,gydF4y2Ba18gydF4y2Ba,gydF4y2Ba19gydF4y2Ba,gydF4y2Ba20.gydF4y2Ba,gydF4y2Ba21gydF4y2Ba,gydF4y2Ba22gydF4y2Ba,gydF4y2Ba23gydF4y2Ba,gydF4y2Ba24gydF4y2Ba。强化学习(RL)是一种基于学习的决策的数学形式,它描述了一种方法,在这种方法中,智能体根据与环境的交互执行顺序动作,从而产生最多的累积奖励gydF4y2Ba25gydF4y2Ba。当与深度神经网络和先进计算相结合时,强化学习的能力被大大增强:深度神经网络可以处理高维输入,而强化学习可以选择复杂的动作。深度强化学习的应用有很多。最著名的例子之一是在围棋游戏中取得超人的表现gydF4y2Ba26gydF4y2Ba,gydF4y2Ba27gydF4y2Ba考虑到10多个项目的复杂性,这一度被认为是一项无法完成的任务gydF4y2Ba140gydF4y2Ba可能的解决方案。在材料科学的背景下,深度强化学习在分子发现和微观结构设计方面取得了进展gydF4y2Ba28gydF4y2Ba,gydF4y2Ba29gydF4y2Ba,gydF4y2Ba30.gydF4y2Ba,gydF4y2Ba31gydF4y2Ba,gydF4y2Ba32gydF4y2Ba,gydF4y2Ba33gydF4y2Ba。更让我们感兴趣的是,深度强化学习在解决困难的组合优化问题方面也有优势。对于这些问题,许多传统的算法涉及到使用手工设计的启发式,依次构建一个解决方案。然而,这种启发式的设计可能是一项令人生畏的任务,需要领域的专业知识,并且由于问题的困难组合性质,通常可能是次优的。因此,在没有人为干预的情况下推断启发式的想法是诱人的。深度强化学习有望学习有效的启发式算法来解决这些问题,并已被用于解决组合优化问题,如旅行推销员问题gydF4y2Ba34gydF4y2Ba,gydF4y2Ba35gydF4y2Ba,gydF4y2Ba36gydF4y2Ba,最大切割问题gydF4y2Ba37gydF4y2Ba,gydF4y2Ba38gydF4y2Ba,gydF4y2Ba39gydF4y2Ba,以及装箱问题gydF4y2Ba40gydF4y2Ba,gydF4y2Ba41gydF4y2Ba,gydF4y2Ba42gydF4y2Ba。gydF4y2Ba

在本研究中,开发了一个深度强化学习框架,通过优化功能群分布来设计机械坚韧的go。在我们的深度强化学习框架中,官能团分配的任务被表述为一个顺序(马尔可夫)决策过程,其中状态是GBP上当前官能团的分布,动作是分配一个新的官能团。采用策略梯度RL模型,通过反应分子动力学(MD)模拟计算氧化石墨烯韧性。我们设计了四个难度的实验来逐步挑战我们的深度强化学习模型,每个难度包括两个具有两种氧化水平的实验。我们的目标是开发一个具有以下特征的深度强化学习模型:(1)稳定生成机械韧性的GO结构;(2)在官能团密度和GBP大小方面具有良好的可扩展性;(3)设计空间大,计算简便。gydF4y2Ba

结果gydF4y2Ba

氧化石墨烯模拟gydF4y2Ba

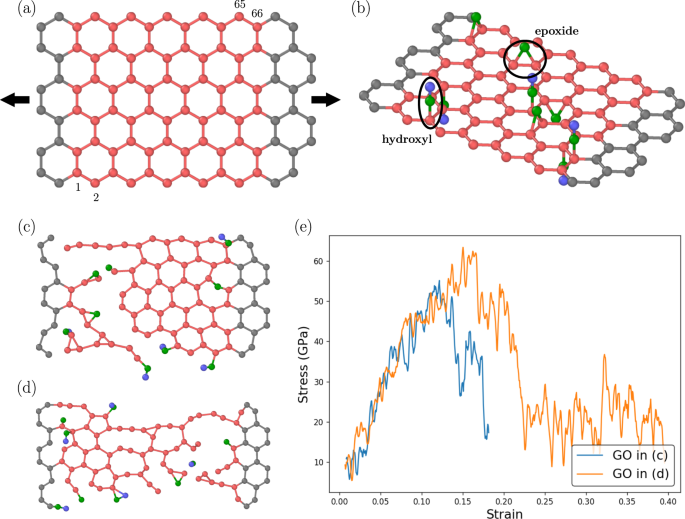

在本研究中,大多数go是基于由94个碳原子组成的GBPs,其中靠近两个相对边缘的28个无官能团的原子被夹住以强制位移,中间的66个自由移动的原子是官能团的活跃宿主(以下称为宿主原子),这些原子的数量用表示gydF4y2BangydF4y2BacgydF4y2Ba),如图所示。gydF4y2Ba1gydF4y2Ba。稍后在更复杂的实验中,将使用大约两倍大小的更大的英镑。在我们的GO模型中,只考虑羟基和环氧化物基团,而忽略了GBP边缘上不太重要的羰基和羧基。数字gydF4y2Ba1 bgydF4y2Ba给出了一个氧化石墨烯模型,并举例说明了羟基和环氧化物基团的分子结构。每个羟基只附着在一个碳原子上,而每个环氧化物则附着在两个相邻的碳原子上。当两个功能组都出现在GBP上时,这种差异增加了优化难度。此外,这些官能团可以附着在GBP的任何一侧。在加载条件下,氧化石墨烯薄片沿GBP之字形方向以恒定加载速度进行单轴拉伸加载。通过反应MD模拟计算了GOs的力学响应,并在方法中提供了实现细节。反应MD模拟有利于模拟纳米材料的破坏,因为它们解释了键断裂和形成,这在纳米尺度上的断裂行为中至关重要。我们在模拟中观察到,在相同数量的羟基和环氧化物基团的情况下,不同的官能团分布会导致本质上不同的应力-应变关系和破坏行为。图中给出了示例。gydF4y2Ba1 c, dgydF4y2Ba。图中GOs。gydF4y2Ba1 c, dgydF4y2Ba有相同数量的羟基和环氧基团,但是图。gydF4y2Ba1 cgydF4y2Ba图4为脆性断裂。gydF4y2Ba1 dgydF4y2Ba显示了一种更具有延展性的破坏,包括相当大的新键形成和结构变化。数字gydF4y2Ba1 egydF4y2Ba对比了上述两种go的应力-应变曲线。可以看出,图中GO。gydF4y2Ba1 dgydF4y2Ba具有较高的极限应力和破坏应变,具有较好的力学性能。材料的韧性可以表示为gydF4y2Ba\ (u = {\ int} _0 ^{{\它{\ε}}_ {{{\ mathrm {f}}}}}{σ\ d{\它{\ε}}}\)gydF4y2Ba,在那里gydF4y2BaugydF4y2Ba韧性;gydF4y2BaϵgydF4y2Ba是应变;gydF4y2BaϵgydF4y2BafgydF4y2Ba是失败时的压力;gydF4y2BaσgydF4y2Ba是压力。根据上述定义,韧性等于应力-应变曲线下的面积。计算出图中GO的韧性。gydF4y2Ba1 dgydF4y2Ba是图中GO的2.1倍。gydF4y2Ba1 cgydF4y2Ba。这种韧性差异表明,官能团的分布可能对氧化石墨烯的机械性能产生深远的影响,因此优化氧化石墨烯的机械性能是值得的。由于官能团分布的不同,两种氧化石墨烯构型也会产生不同的面外变形,其结果在补充资料中提供。gydF4y2Ba

深度强化学习gydF4y2Ba

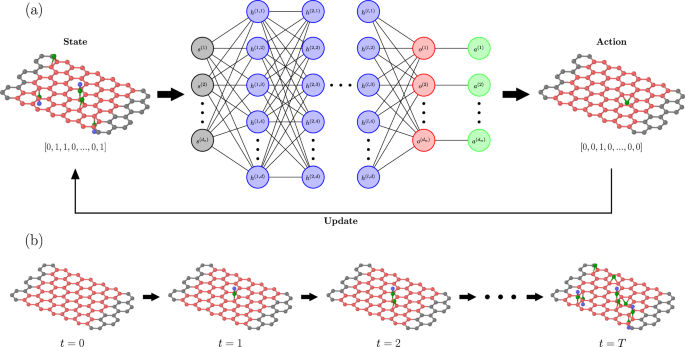

我们要解决的优化问题是给定固定数量的羟基和环氧化物基团,如何将这些官能团分布在GBP上,使GO的韧性最大化。我们不再把优化问题看作是一次性选择最佳功能群分布,而是将功能群分配问题建模为一个顺序决策过程,并使用强化学习来求解。更具体地说,每个单独的功能组在离散时间步长的序列中被分配到GBP上的一个位置gydF4y2Bat =gydF4y2Ba0,1,2,gydF4y2Ba…TgydF4y2Ba,在那里gydF4y2BaTgydF4y2Ba等于官能团的总数。在每个时间步gydF4y2BatgydF4y2Ba, RL代理接收环境状态的表示gydF4y2Ba年代gydF4y2BatgydF4y2Ba,这是当前官能团的位置。在我们的设置中,状态空间是一个离散集合,包含了与GBP上单个碳原子或碳原子对相关的所有官能团可能性,并且在连续欧几里得空间中没有定义。接收到状态后gydF4y2Ba年代gydF4y2BatgydF4y2Ba, RL代理选择一个动作gydF4y2Ba一个gydF4y2BatgydF4y2Ba,即将一个官能团分配给英镑上的一个官能团点。这是由政策完成的gydF4y2BaπgydF4y2BaθgydF4y2Ba,在那里gydF4y2BaπgydF4y2BaθgydF4y2Ba(gydF4y2Ba一个gydF4y2BatgydF4y2Ba|gydF4y2Ba年代gydF4y2BatgydF4y2Ba)为选择该动作的概率gydF4y2Ba一个gydF4y2BatgydF4y2Ba如果国家是gydF4y2Ba年代gydF4y2BatgydF4y2Ba在policy参数下gydF4y2BaθgydF4y2Ba,也就是说,gydF4y2Ba\(θ\π_ \ \离开({{{{\ mathbf{一}}}}_t {{{\ mathrm {|}}}}{{{\ mathbf{年代}}}}_t} \右)= {\ Bbb P} \左({{{{\ mathbf{一}}}}_t {{{\ mathrm {|}}}}{{{\ mathbf{年代}}}}_t; \θ}\)\)gydF4y2Ba。在采取行动之后gydF4y2Ba一个gydF4y2BatgydF4y2Ba在国家gydF4y2Ba年代gydF4y2BatgydF4y2Ba,代理进入新的状态gydF4y2Ba年代gydF4y2BatgydF4y2Ba+ 1gydF4y2Ba,这个过程被称为状态转换。涉及策略网络和动作的状态转换过程如图所示。gydF4y2Ba2gydF4y2Ba。轨迹公式为gydF4y2Ba\ ({{{\ mathcal {T}}}} =左\ \ {{{{{\ mathbf{年代}}}}_0,{{{\ mathbf{一}}}}_0,{{{\ mathbf{年代}}}}_1,{{{\ mathbf{一}}}}_1,\ ldots, {{{\ mathbf{年代}}}}_ {T - 1}, {{{\ mathbf{一}}}}_ {T - 1}, {{{\ mathbf{年代}}}}_T} \右\}\)gydF4y2Ba,整个示例轨迹的氧化石墨烯构型如图所示。gydF4y2Ba2 bgydF4y2Ba。进入一个新状态时gydF4y2Ba年代gydF4y2BatgydF4y2Ba+ 1gydF4y2Ba, RL代理也会收到一个数字奖励gydF4y2Ba\ (r_ {t + 1} = r \离开({{{{\ mathbf{年代}}}}_ {t + 1}} \右){\ Bbb r} \ \)gydF4y2Ba。我们将奖励设定为gydF4y2Ba

在哪里gydF4y2Ba\(\hat u\left({s_t} \right)\)gydF4y2Ba标准韧性是由gydF4y2Ba

在哪里gydF4y2BaμgydF4y2BaugydF4y2Ba和gydF4y2BaσgydF4y2BaugydF4y2Ba为随机GOs的均值和标准差。对于每条轨迹,MD仿真只在最后一步运行一次,当所有功能组都被分配到获得唯一的非零奖励时gydF4y2BaugydF4y2Ba(gydF4y2Ba年代gydF4y2BaTgydF4y2Ba).本研究中所有RL成分总结于表中gydF4y2Ba1gydF4y2Ba,有关RL实现的更多细节请参阅Methods。gydF4y2Ba

为了使用强化学习进行GO优化,我们逐步增加了实验的复杂性,并设计了四个难度级别:简单、中等、困难和特别困难。对于Easy实验,只有羟基被分配到GBP的一侧。在Medium实验中,只有羟基被分配到GBP上,但它们可以分配到GBP的两侧。中等实验比简单实验复杂,状态空间和动作空间的大小增加了一倍。对于Hard实验,羟基和环氧基团都被分配到GBP上,它们可以分配到GBP的两侧。Hard实验的设置类似于现实中的GOs,涉及羟基和环氧化物基团之间的竞争。Extra Hard实验与Hard实验类似,但使用了更大的GBP,由120个功能基团宿主组成,而之前的所有实验都是66个。所有实验难点的描述汇总在表中gydF4y2Ba2gydF4y2Ba。此外,每个难度都包含两个氧化水平:低和高,其中前者的氧碳比约为15%,后者则是其两倍。Extra Hard难度用于测试氧化石墨烯大小的可扩展性,而不同的氧化水平用于测试官能团密度的可扩展性。总之,我们总共有8个不同的实验来挑战我们的深度强化学习算法,每个实验的结果都是基于4个不同的随机种子来评估的。羟基、环氧化物基团和主原子的数目列于表中gydF4y2Ba3.gydF4y2Ba。在所有的实验中,无效的行为可以简单地描述为将一个官能团分配给GBP上已经占据的碳原子。然而,随着难度的增加,消除无效行为成为一个越来越微妙的过程,这在补充资料中有详细说明。计算公式()所示的奖励gydF4y2Ba1gydF4y2Ba),平均值gydF4y2BaμgydF4y2BaugydF4y2Ba和gydF4y2BaσgydF4y2BaugydF4y2Ba的随机GO配置。所有实验中2000个随机GOs的均值和标准差汇总于表中gydF4y2Ba4gydF4y2Ba,分布直方图见补充资料。gydF4y2Ba

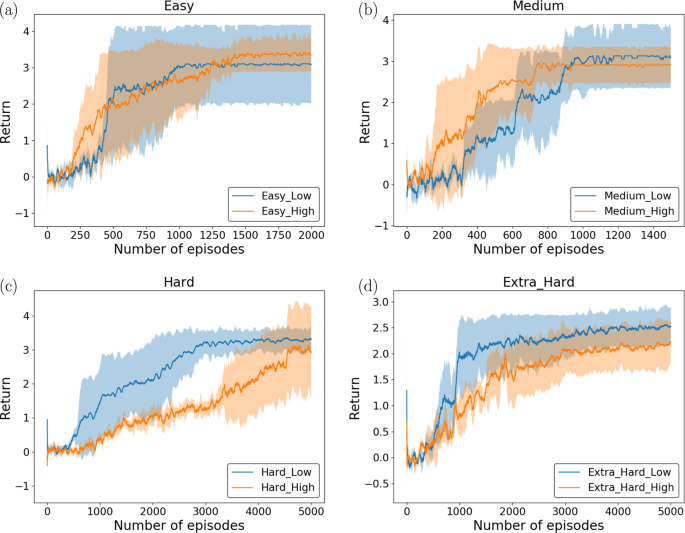

算法也会随着实验的不同而变化。对于Easy和Medium实验,只有一个策略网络gydF4y2BaπgydF4y2BaθgydF4y2Ba用于将状态映射为所有合法行为的概率分布,即将羟基分配给可用点。然而,对于Hard和Extra Hard实验,需要两个策略网络来分配两种类型的功能组。我们用羟基表示网络gydF4y2Ba\(\pi _\theta ^{{{\ mathm {h}}}}\)gydF4y2Ba还有环氧基的网络gydF4y2Ba\(\pi _\rho ^{{{\ mathm {e}}}}\)gydF4y2Ba,在那里gydF4y2BaθgydF4y2Ba和gydF4y2BaρgydF4y2Ba是各自的网络参数。接下来,我们需要决定分配羟基和环氧基团的顺序。因为只有在终端步骤才会观察到非零奖励,所以只有分配最后一个功能群的网络才会通过反向传播更新其参数。因此,分配序列不可能是确定性的,因为我们需要改进这两个网络。为此,我们使用伯努利分布gydF4y2Ba\ (rm{伯努利}}{\ \离开({m_ {{{\ mathrm {h}}}} / \离开({m_ {{{\ mathrm {h}}}} / m_ {{{\ mathrm {e}}}}} \右)}\)\)gydF4y2Ba采样每一步使用的网络索引,其中gydF4y2Ba米gydF4y2BahgydF4y2Ba和gydF4y2Ba米gydF4y2BaegydF4y2Ba是在当前时间步留下的待分配的羟基和环氧化物基团的数目。这种方法随机化了每集的功能组分配顺序,并给两个网络一个更新参数的机会。这两种策略梯度算法的伪码在补充资料中进行了总结。数字gydF4y2Ba3.gydF4y2Ba给出了8个实验的深度强化学习优化结果。返回值的数值表示该设计比具有相同数量官能团的随机GOs的平均值高出多少个标准差(汇总见表)gydF4y2Ba4gydF4y2Ba).如图所示。gydF4y2Ba3得了gydF4y2Ba在Easy, Medium和Hard实验中,最终的平均回报率达到3左右,这表明RL生成的GO官能团分布比99.87%的GO配置具有更高的韧性。在Extra Hard实验中,我们的模型获得了大于2的收益,从而击败了97.73%的go(图2)。gydF4y2Ba3 dgydF4y2Ba).此外,所有实验仅在5000集内达到局部最大值(每次实验运行不超过5000个MD模拟),这远远小于可能的GO配置数量。对于Easy难度,低氧化和高氧化实验有CgydF4y2Ba10gydF4y2Ba(66) = 2.1 × 10gydF4y2Ba11gydF4y2Ba和CgydF4y2Ba20.gydF4y2Ba(66) = 4.1 × 10gydF4y2Ba16gydF4y2Ba可能的官能团排列,在更困难的实验中甚至有更多的排列可能性。最后但并非最不重要的是,在不同氧化水平和Extra Hard实验中的良好表现表明,我们的RL设计方法在官能团密度和氧化石墨烯尺寸方面是可扩展的。所有实验的策略网络架构/参数在方法中给出。我们的RL设计在前2000集的分布直方图(与2000个随机go的分布进行比较)和完整的5000集在补充信息中提供。gydF4y2Ba

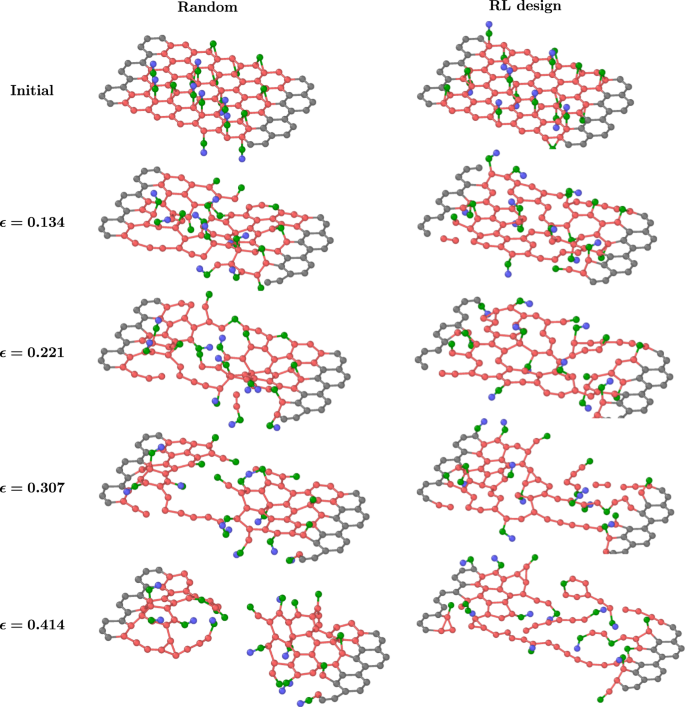

最后,为了从微观结构的角度获得见解,我们比较了随机氧化石墨烯和rl设计氧化石墨烯的分子结构和详细的失效行为。这两种氧化石墨烯样品取自高氧化硬实验,两种氧化石墨烯在不同应变下的对比如图所示。gydF4y2Ba4gydF4y2Ba。从初始配置来看,RL设计的官能团分布比随机GO更分散。然而,对于如何设计特定的官能团排列以获得高韧性,人们几乎没有直观的认识。随着应变的增加,氧化石墨烯沿明确的路径随机断裂,而RL设计的氧化石墨烯从多个点开始断裂,形成网状结构,其中包含大量新键的形成。这一现象表明,RL设计的氧化石墨烯具有更多有助于吸收能量的原子,最终导致更高的韧性(11.88 GPa比随机氧化石墨烯的4.96 GPa)。为了获得更多关于氧化石墨烯坚韧性的物理见解,我们进行了分析,以确定高韧性氧化石墨烯更常占据的官能团位点。具体而言,我们计算了高韧性go在所有难度等级下每个可能的官能团位点上的官能团出现的数量,结果在补充资料中提供。结果表明,高韧性石墨烯上的官能团更有可能分布在边缘附近,而不是在中心。我们将这一观察结果解释为:官能团通常对氧化石墨烯的韧性有负面影响,将官能团分布在远离中心的地方有助于减轻这种影响。随机氧化石墨烯结构的韧性结果支持了这一点,其中高氧化总是比低氧化具有更低的平均韧性。 However, it is shown that highly occupied functional group sites are not located only near the edges, and some sites inside the GBP also have a high occupancy. This may be explained by the involvement of other more complex mechanisms such as the interaction between functional groups, which emphasizes the necessity of using our RL-based design approach to solve this challenging problem.

讨论gydF4y2Ba

我们的RL框架是基于政策的,其中RL代理需要为每个情节采样一个新的轨迹。在我们的问题设置中,将调用MD仿真,在每个轨迹的最后一步运行,根据式()生成奖励。gydF4y2Ba1gydF4y2Ba),这是花费最多计算的地方。未来的工作包括开发一个代理模型,该模型将状态作为输入,并输出奖励,以减轻RL部署期间MD模拟的计算。另一个问题来自于目前的双重政策网络设计。在每一集中,只有一个网络可以得到改进,而另一个网络保持不变,这不是一个特别有效的数据算法设计。此外,当两类功能群数量不平衡时,少数功能群类型的政策网络可能更新很慢。未来的工作包括设计一个更好的策略网络架构来解决或缓解上述两个问题。gydF4y2Ba

对于非均相或无序的纳米尺度体系,在体系较小的情况下,缺陷或官能团的排列对材料性能有重大影响。但随着系统规模的增大,官能团个体缺陷的影响逐渐减小。可以预期,在功能群位置上进行优化的潜力将变得不那么重要。在未来的工作中,我们将进一步研究官能团位置对GOs力学性能的影响作为系统大小的函数,以及其基于rl的优化能力。本研究的另一个局限性是,我们没有考虑设计的氧化石墨烯的热力学,这意味着输出的氧化石墨烯构型可能不热稳定。我们想指出的是,我们的深度强化学习设计方法在以下方面仍然具有价值。首先,该方法可以作为有效的材料层筛选。例如,我们可以输出100个Deep RL设计,然后应用热力学标准来选择机械性能优越和热稳定的候选产品。其次,我们可以修改RL算法中的奖励,使其有利于热稳定的氧化石墨烯。具体来说,我们可以将每个氧的结合能包含在奖励中,可以表示为gydF4y2Ba

在哪里gydF4y2BaEgydF4y2Ba去gydF4y2Ba,gydF4y2BaEgydF4y2BaggydF4y2Ba,gydF4y2BaEgydF4y2BahgydF4y2Ba分别为氧化石墨烯结构、纯石墨烯和羟基的总能量。我们将在未来的工作中研究这种方法。第三,考虑到化学成分和尺寸,我们的RL方法可以有效地建立氧化石墨烯力学性能的上限。gydF4y2Ba

总之,我们开发了一个深度强化学习框架,通过优化官能团分布来设计高韧性的go。设计任务被表述为一个顺序决策过程,其中状态是GBP上当前功能组的分布,动作是分配一个新的功能组。采用策略梯度RL模型,通过反应分子动力学模拟计算氧化石墨烯的韧性。设计了八个难度越来越大的实验来逐步挑战我们的深度强化学习模型。在前6次实验中,我们的模型可以稳定地生成比随机go的平均值高3个标准差的官能团分布,这表明RL生成的go的韧性高于所有go的98.87%。在最后两个最困难的实验中,我们的模型比随机GOs的平均值高出两个标准差,从而击败了97.73%的GOs。此外,我们的强化学习方法仅在5000次部署中就达到了优化的功能组分布,而最简单的实验有CgydF4y2Ba10gydF4y2Ba(66) = 2.1 × 10gydF4y2Ba11gydF4y2Ba的可能性。最后,我们证明了我们的RL设计方法在官能团密度和GO大小方面是可扩展的。本研究展示了官能团分布对氧化石墨烯性质的影响,并说明了深度强化学习在优化氧化石墨烯方面的有效性和数据效率。gydF4y2Ba

方法gydF4y2Ba

深度RL设置gydF4y2Ba

在每个时间步gydF4y2BatgydF4y2Ba, RL代理接收环境状态的表示gydF4y2Ba\({{\mathbf{s}}}}_t \in {{\mathbf{s}}}} \)gydF4y2Ba,在那里gydF4y2Ba年代gydF4y2Ba是包含所有可能状态的状态空间。在我们的例子中,gydF4y2Ba年代gydF4y2BatgydF4y2Ba当前的官能团是否在时间步长位置gydF4y2BatgydF4y2Ba,gydF4y2Ba年代gydF4y2Ba表示GBP上所有可能的官能团位置的集合。我们构建gydF4y2Ba年代gydF4y2BatgydF4y2Ba作为一个单热编码向量,其维数等于GBP上官能团的所有可能点的个数。以Easy实验为例,得到gydF4y2Ba年代gydF4y2BatgydF4y2Ba是66,因为羟基总共有66个位置。如果我们同时使用羟基和环氧基,那么gydF4y2Ba年代gydF4y2BatgydF4y2Ba会增加到所有可能的环氧基团的位置。如果gydF4y2Ba我gydF4y2Ba该点已被分配了一个功能组,值的gydF4y2Ba我gydF4y2Ba的条目gydF4y2Ba年代gydF4y2BatgydF4y2Ba,gydF4y2Ba年代gydF4y2BatgydF4y2Ba[gydF4y2Ba我gydF4y2Ba],为1;否则,gydF4y2Ba年代gydF4y2BatgydF4y2Ba[gydF4y2Ba我gydF4y2Ba]为0。1的个数gydF4y2Ba年代gydF4y2BatgydF4y2Ba等于在时间步骤上已经分配的官能团的数量gydF4y2BatgydF4y2Ba。接收到状态后gydF4y2Ba年代gydF4y2BatgydF4y2Ba, RL代理选择一个动作gydF4y2Ba\ ({{{\ mathbf{一}}}}_t \在{{{\ mathcal{一}}}}({{{\ mathbf{年代}}}}_t) \)gydF4y2Ba,在那里gydF4y2Ba\ ({{{\ mathcal{一}}}}({{{\ mathbf{年代}}}}_t) \)gydF4y2Ba这一系列的法律行为是国家规定的吗gydF4y2Ba年代gydF4y2BatgydF4y2Ba。在我们的例子中,gydF4y2Ba一个gydF4y2BatgydF4y2Ba是将一个官能团分配给英镑上的一个官能团点,以及gydF4y2Ba\ ({{{\ mathcal{一}}}}({{{\ mathbf{年代}}}}_t) \)gydF4y2Ba所有可用的官能团点的集合是否已知gydF4y2Ba年代gydF4y2BatgydF4y2Ba。gydF4y2Ba一个gydF4y2BatgydF4y2Ba也是一个单热编码向量,其维数等于指定特定类型官能团的可能点的数量。在我们的强化学习框架中,gydF4y2Ba一个gydF4y2BatgydF4y2Ba不同于gydF4y2Ba年代gydF4y2BatgydF4y2Ba在那gydF4y2Ba一个gydF4y2BatgydF4y2Ba只占一种特定类型的官能团(羟基或环氧基),而gydF4y2Ba年代gydF4y2BatgydF4y2Ba两种类型的帐户。如果动作是将一个功能组分配给gydF4y2Ba我gydF4y2Ba在所有可能的点中,gydF4y2Ba一个gydF4y2BatgydF4y2Ba[gydF4y2Ba我gydF4y2Ba= 1。由于每个操作仅限于分配一个功能组,因此只有一个1条目gydF4y2Ba一个gydF4y2BatgydF4y2Ba。在本工作中,我们使用神经网络对策略进行建模gydF4y2BaπgydF4y2BaθgydF4y2Ba,在那里gydF4y2BaθgydF4y2Ba是神经网络参数,包括权重和偏置。此外,gydF4y2Ba一个gydF4y2BatgydF4y2Ba是由宿主原子在GBP上的杂化条件严格执行的,这要求一个宿主原子只能与一个官能团结合。因此,在每个功能组分配之后,一个或多个操作将在下一个时间步骤中变得不可行的,并且选择这些操作的可能性将被设置为零。无效行为的消除过程取决于实施RL的实验的性质,并在补充资料中详细说明。在采取行动之后gydF4y2Ba一个gydF4y2BatgydF4y2Ba在国家gydF4y2Ba年代gydF4y2BatgydF4y2Ba,代理进入新的状态gydF4y2Ba年代gydF4y2Bat +gydF4y2Ba1gydF4y2Ba。在我们的上下文中,将一个官能团分配给当前GO后,我们获得一个新的GO。在补充信息中的算法1和算法2中总结了如何在每个时间步获得状态和动作的详细信息。状态转换函数gydF4y2BagydF4y2Ba定义选择动作后的后继状态gydF4y2Ba一个gydF4y2Ba在某种状态下gydF4y2Ba年代gydF4y2Ba随机输入gydF4y2BagydF4y2Ba。在目前的研究中,状态转换是确定性的;gydF4y2BagydF4y2Ba。值得注意的是,我们的状态具有马尔可夫属性,其中未来状态仅取决于当前状态,而不取决于过去状态,即:gydF4y2Ba\ ({\ Bbb P} \离开({{{{\ mathbf{年代}}}}_ {t + 1} {{{\ mathrm {|}}}}{{{\ mathbf{年代}}}}_t, {{{\ mathbf{年代}}}}_ {t - 1}, \ ldots, {{{\ mathbf{年代}}}}_1,{{{\ mathbf{年代}}}}_0}\)\)gydF4y2Ba=gydF4y2Ba\ ({\ Bbb P} \离开({{{{\ mathbf{年代}}}}_ {t + 1} {{{\ mathrm {|}}}}{{{\ mathbf{年代}}}}_t} \) \)gydF4y2Ba。GBP上的官能团位置作为一个马尔可夫状态,它总结了导致它的官能团分配历史。gydF4y2Ba

强化学习的目标是最大化预期收益,其中收益是奖励序列的函数。然而,基于式()中的奖励设置。gydF4y2Ba1gydF4y2Ba),代理只会在终端步骤获得非零奖励。这是受到AlphaGo研究的启发,在AlphaGo研究中,智能体只在游戏结束时获得非零奖励:gydF4y2BargydF4y2Ba= 1,如果代理赢了游戏;如果座席输了,R =−1。本研究采用策略梯度算法实现期望收益最大化,通过梯度下降直接优化参数化策略。具体来说,是一项政策gydF4y2BaπgydF4y2BaθgydF4y2Ba(gydF4y2Ba一个gydF4y2Ba|gydF4y2Ba年代gydF4y2Ba)参数化gydF4y2BaθgydF4y2Ba,每次事件后参数的变化(采样一个完整的轨迹)gydF4y2Ba\ ({{{\ mathcal {T}}}} \)gydF4y2Ba)由gydF4y2Ba43gydF4y2Ba

使用我们的蒙特卡罗采样gydF4y2Ba

因此,在本研究中,我们每条轨迹更新一次策略网络参数gydF4y2BaNgydF4y2Ba= 1。我们到达gydF4y2Ba

参数更新如下gydF4y2BaθgydF4y2Ba←gydF4y2BaθgydF4y2Ba+gydF4y2BaαgydF4y2BaΔgydF4y2BaθgydF4y2Ba,在那里gydF4y2BaαgydF4y2Ba是当前的学习率。gydF4y2Ba

神经网络gydF4y2Ba

对于所有的实验,我们使用各种大小和ReLU激活的全连接神经网络。在最后一层,我们使用一个完全连接的层,然后是一个输出动作概率分布的softmax激活,作为解决探索与利用困境的一种方法。不同实验的输入和输出维度如表所示gydF4y2Ba5gydF4y2Ba。gydF4y2Ba

接下来,我们将选择无效行为的概率设为零,并重新规范化分布,使每个时间步上所有合法行为的概率之和等于1。使用了Adam优化器。学习率每500次迭代缩小2倍,但设置为不小于5e-5。所有实验中使用的大小和初始学习率汇总在表中gydF4y2Ba6gydF4y2Ba。初始化权重和偏差gydF4y2Ba\ ({{{\ mathcal{你}}}}\离开({- 1 / \√{d_ {{{{\ mathrm{在}}}}}},1 / \√{d_ {{{{\ mathrm { }}}}}} } \ 右)\)gydF4y2Ba,在那里gydF4y2Ba\ ({{{\ mathcal{你}}}}\)gydF4y2Ba表示均匀分布,且gydF4y2BadgydF4y2Ba在gydF4y2Ba表示每一层的输入维数。gydF4y2Ba

分子动力学模拟gydF4y2Ba

分子动力学模拟使用开源代码LAMMPS(大规模原子/分子大规模并行模拟器)进行。gydF4y2Ba44gydF4y2Ba。采用ReaxFF势(一种反应力场)来模拟氧化石墨烯中碳、氢、氧原子之间的相互作用gydF4y2Ba45gydF4y2Ba。ReaxFF势模型既包括范德华和库仑相互作用等非键相互作用,也包括键断裂和键形成。具体来说,参考文献中开发的潜在参数。gydF4y2Ba45gydF4y2Ba。被各种关于石墨烯系统的物理和化学行为的研究证明是可靠的gydF4y2Ba46gydF4y2Ba,gydF4y2Ba47gydF4y2Ba,gydF4y2Ba48gydF4y2Ba,gydF4y2Ba49gydF4y2Ba。采用了三维全原子模型。周期边界条件应用于所有三个空间维度。对于易、中、难实验,模拟箱的大小初始化为58.5 Å × 21.4 Å × 15.2 Å,对于特难实验,模拟箱的大小初始化为63.3 Å × 25.6 Å × 15.2 Å。运动方程以0.1 fs (0.1 × 10)的时间步长进行积分gydF4y2Ba−15gydF4y2Ba5)采用Verlet算法,保证了计算的稳定性。每10个时间步记录一次所有原子的轨迹、速度、力和能量。为了模拟室温下的拉伸载荷,首先在所有原子中产生一个对应于300 K温度的随机速度系综。然后用Nose-Hoover恒温器在等温-等压(NPT)系统中进行模拟,实现了平衡gydF4y2Ba50gydF4y2Ba在相同的温度下保持5000个时间步长。在300 K的标准(NVT)集成中模拟了加载场景。单向面内拉伸荷载以变形控制方式沿之字形方向施加,直至破坏。加载速度为1000 m·sgydF4y2Ba−1gydF4y2Ba。在NPT模拟过程中,箱体尺寸变化很小,而在NVT模拟过程中,箱体尺寸不变。图中箱体尺寸随时间的变化。gydF4y2Ba1 c, dgydF4y2Ba示例在补充信息中提供。gydF4y2Ba

应力张量[σ]的分量计算如下:gydF4y2Ba

在哪里gydF4y2Ba一个gydF4y2Ba和gydF4y2BabgydF4y2Ba取空间维度1(锯齿形)、2(扶手椅)或3(平面外)来生成对称张量的6个独立分量;Ω=gydF4y2Ba在gydF4y2BaegydF4y2Ba为系统体积;gydF4y2Ba一个gydF4y2Ba为英镑的面积;gydF4y2BatgydF4y2BaegydF4y2Ba为氧化石墨烯的有效厚度;gydF4y2Ba我gydF4y2Ba和gydF4y2BajgydF4y2Ba是原子指标;gydF4y2BaxgydF4y2Ba为位移;gydF4y2Ba\ (x \ \点)gydF4y2Ba表示的导数gydF4y2BaxgydF4y2Ba关于时间的;gydF4y2BaVgydF4y2Ba是原子间势模型。在这项研究中,gydF4y2Ba\(t_{{\mathrm{e}}}} = 7.76\,{\AA}\)gydF4y2Ba,则实验中测量到的go的层间间距gydF4y2Ba51gydF4y2Ba,gydF4y2Ba52gydF4y2Ba。gydF4y2Ba

数据可用性gydF4y2Ba

本工作中使用的所有数据都可以使用代码at生成gydF4y2Bahttps://github.com/BOWENmeZHENG/go_rlgydF4y2Ba。gydF4y2Ba

代码的可用性gydF4y2Ba

本工作中的所有代码均可在gydF4y2Bahttps://github.com/BOWENmeZHENG/go_rlgydF4y2Ba。gydF4y2Ba

参考文献gydF4y2Ba

Novoselov, k.s.等。原子薄碳薄膜中的电场效应。gydF4y2Ba科学gydF4y2Ba306gydF4y2Ba, 666-669(2004)。gydF4y2Ba

Huang, M, Pascal, T. A, Kim, H., Goddard, W. A.和Greer, J. R.石墨烯中电子-机械耦合的原位纳米压痕实验和多尺度原子模拟。gydF4y2BaNano。gydF4y2Ba11gydF4y2Ba, 1241-1246(2011)。gydF4y2Ba

郑斌,顾国祥。基于缺陷工程的石墨烯力学各向异性调谐。gydF4y2Ba碳gydF4y2Ba155gydF4y2Ba, 697-705(2019)。gydF4y2Ba

cracion, M. F., Russo, S., Yamamoto, M. & Tarucha, S.石墨烯的可调谐电子特性。gydF4y2Ba纳米今天gydF4y2Ba6gydF4y2Ba, 42-60(2011)。gydF4y2Ba

郑斌,郑铮,顾国祥。基于可迁移学习的可扩展石墨烯缺陷预测。gydF4y2Ba纳米材料gydF4y2Ba11gydF4y2Ba, 2341(2021)。gydF4y2Ba

Wei, Z.等。用于石墨烯电子学的氧化石墨烯纳米级可调还原。gydF4y2Ba科学gydF4y2Ba328gydF4y2Ba中文信息学报,1373-1376(2010)。gydF4y2Ba

吴,x,等。外延-石墨烯/石墨烯-氧化物结:迈向外延石墨烯电子学的重要一步。gydF4y2Ba理论物理。启。gydF4y2Ba101gydF4y2Ba, 026801(2008)。gydF4y2Ba

Chung, C.等。石墨烯和氧化石墨烯的生物医学应用。gydF4y2BaAcc。化学。Res。gydF4y2Ba46gydF4y2Ba, 2211-2224(2013)。gydF4y2Ba

Lee, J., Kim, J., Kim, S.和Min, D.-H.。基于氧化石墨烯的生物传感器及其生物医学应用。gydF4y2Ba药物输送牧师。gydF4y2Ba105gydF4y2Ba, 275-287(2016)。gydF4y2Ba

Bo, Z.等。用于传感和储能应用的还原氧化石墨烯的绿色制备。gydF4y2Ba科学。代表。gydF4y2Ba4gydF4y2Ba, 4684(2014)。gydF4y2Ba

徐军,王凯,祖绍忠。汉,b - h。&魏铮。氧化石墨烯片上聚苯胺纳米线阵列的层次化纳米复合材料及其储能协同效应。gydF4y2BaACS NanogydF4y2Ba4gydF4y2Ba, 5019-5026(2010)。gydF4y2Ba

陈,C.-T。,Martin-Martinez, F. J., Ling, S., Qin, Z. & Buehler, M. J. Nacre-inspired design of graphene oxide–polydopamine nanocomposites for enhanced mechanical properties and multi-functionalities.纳米期货gydF4y2Ba1gydF4y2Ba, 011003(2017)。gydF4y2Ba

Johari, P. & Shenoy, V. B.氧化石墨烯的调制光学特性:突出官能团的作用。gydF4y2BaACS NanogydF4y2Ba5gydF4y2Ba, 7640-7647(2011)。gydF4y2Ba

郑斌,顾国祥。基于梯度增强的氧化石墨烯功能化预测:对材料化学成分识别的影响。gydF4y2BaACS达成。纳米板牙。gydF4y2Ba4gydF4y2Ba中文信息学报,3167-3174(2021)。gydF4y2Ba

魏,x,等。氧化石墨烯的塑性和延展性是通过机械化学诱导的损伤容限机制实现的。gydF4y2BaCommun Nat。gydF4y2Ba6gydF4y2Ba, 8029(2015)。gydF4y2Ba

Jin, Z., Zhang, Z., Demir, K. & Gu, g.x.先进增材制造的机器学习。gydF4y2Ba事gydF4y2Ba3.gydF4y2Ba[j] .中国科学:自然科学版,2015(5)。gydF4y2Ba

Theodoridis, S。gydF4y2Ba机器学习:贝叶斯和优化的视角gydF4y2Ba(学术出版社,2015)。gydF4y2Ba

Butler, K. T., Davies, D. W., Cartwright, H., Isayev, O.和Walsh, A.分子和材料科学的机器学习。gydF4y2Ba自然gydF4y2Ba559gydF4y2Ba, 547-555(2018)。gydF4y2Ba

Karniadakis, g.e.等。基于物理的机器学习。gydF4y2BaNat, Rev. Phys。gydF4y2Ba3.gydF4y2Ba, 422-440(2021)。gydF4y2Ba

李世生,张志和顾国祥。基于生成式机器学习的具有优异力学性能的晶格结构。gydF4y2Ba板牙。水平的。gydF4y2Ba9gydF4y2Ba, 952-960(2022)。gydF4y2Ba

陈,C.-T。&顾国祥。用深度神经网络学习隐藏弹性。gydF4y2Ba自然科学进展。美国gydF4y2Ba118gydF4y2Ba, e2102721118(2021)。gydF4y2Ba

李世峰,白海峰,谢泼德,李世峰,赵海峰。柔性材料、机械、机器人和触觉界面的生物启发设计和增材制造。gydF4y2BaAngew。化学。Int。艾德。gydF4y2Ba58gydF4y2Ba中文信息学报,11182-11204(2019)。gydF4y2Ba

顾国祥,陈春涛。,Richmond, D. J. & Buehler, M. J. Bioinspired hierarchical composite design using machine learning: simulation, additive manufacturing, and experiment.板牙。水平的。gydF4y2Ba5gydF4y2Ba, 939-945(2018)。gydF4y2Ba

郑斌,顾国祥。基于机器学习的石墨烯原子精度缺陷检测。gydF4y2Ba纳米。gydF4y2Ba12gydF4y2Ba, 1-13(2020)。gydF4y2Ba

萨顿,r.s.和巴托,a.g.。gydF4y2Ba强化学习:导论gydF4y2Ba。第二版。(MIT出版社,2018)。gydF4y2Ba

Silver, D.等人。掌握游戏与深度神经网络和树搜索的围棋。gydF4y2Ba自然gydF4y2Ba529gydF4y2Ba, 484-489(2016)。gydF4y2Ba

Silver, D.等人。在没有人类知识的情况下掌握围棋。gydF4y2Ba自然gydF4y2Ba550gydF4y2Ba, 354-359(2017)。gydF4y2Ba

Popova, M., Isayev, O.和Tropsha, A.用于新药物设计的深度强化学习。gydF4y2Ba科学。睡觉。gydF4y2Ba4gydF4y2Ba, eaap7885(2018)。gydF4y2Ba

普京等人。用于从头分子设计的增强对抗神经计算机。gydF4y2Baj .化学。正无穷。模型。gydF4y2Ba58gydF4y2Ba, 1194-1204(2018)。gydF4y2Ba

周忠,Kearnes, S., Li, L., Zare, R. N. & Riley, P.基于深度强化学习的分子优化。gydF4y2Ba科学。代表。gydF4y2Ba9gydF4y2Ba, 10752(2019)。gydF4y2Ba

孙,H. &马,L.基于密度的结构拓扑优化中使用强化学习探索方法的生成设计。gydF4y2Ba设计gydF4y2Ba4gydF4y2Ba, 10(2020)。gydF4y2Ba

隋锋,郭锐,张忠,顾国祥,林林。基于深度强化学习的数字化材料设计。gydF4y2BaACS板牙。列托人。gydF4y2Ba3.gydF4y2Ba中文信息学报,1433-1439(2021)。gydF4y2Ba

Rajak, P.等。基于自主强化学习的二维材料可拉伸基利格米设计。gydF4y2Banpj第一版。板牙。gydF4y2Ba7gydF4y2Ba, 102(2021)。gydF4y2Ba

Bello, I., Pham, H., Le, Q. V., Norouzi, M. & Bengio, S.基于强化学习的神经组合优化。gydF4y2Ba预印在gydF4y2Bahttps://doi.org/10.48550/arXiv.1611.09940gydF4y2Ba(2016)。gydF4y2Ba

Khalil, E., Dai, H., Zhang, Y., Dilkina, B. & Song, L.基于图的学习组合优化算法。gydF4y2Ba神经信息处理。系统。gydF4y2Ba,gydF4y2Bahttps://papers.neurips.cc/paper/2017/file/d9896106ca9896198d9896103d9896105b9896108cbdf9896104fd9896108b9896113a9896101-Paper.pdfgydF4y2Ba(2017)。gydF4y2Ba

Nazari, M, oroojloy, A., Snyder, L. & Takác, M.解决车辆路线问题的强化学习。gydF4y2Ba神经信息处理。系统。gydF4y2Ba,gydF4y2Bahttps://proceedings.neurips.cc/paper/2018/file/2019fb4651c2005b2012ed2070fba2015afe2010b2039a2550-Paper.pdfgydF4y2Ba(2018)。gydF4y2Ba

Barrett, T., Clements, W., Foerster, J. & Lvovsky, A.探索性组合优化与强化学习。gydF4y2Ba程序AAAI Conf. Artif。智能。gydF4y2Ba34gydF4y2Ba中文信息学报,3243-3250(2020)。gydF4y2Ba

Tang, Y., Agrawal, S.和Faenza, Y.整数规划的强化学习:学习切割。gydF4y2BaInt。相依马赫。学习。gydF4y2Ba,gydF4y2Bahttps://doi.org/10.48550/arXiv.1906.04859gydF4y2Ba(2020)。gydF4y2Ba

Cappart, Q., Goutierre, E., Bergman, D.和Rousseau, l - m .。使用机器学习改进优化边界:决策图满足深度强化学习。gydF4y2Ba程序AAAI Conf. Artif。智能。gydF4y2Ba33gydF4y2Ba中文信息学报,1443-1451(2019)。gydF4y2Ba

胡辉,张晓明,闫晓明,王磊,徐宇,一种基于深度强化学习的三维装箱问题求解方法。gydF4y2BaarXivgydF4y2Bahttps://doi.org/10.48550/arXiv.1708.05930gydF4y2Ba(2017)。gydF4y2Ba

Duan, L.等。求解三维柔性装箱问题的多任务选择学习方法。gydF4y2BaarXivgydF4y2Bahttps://doi.org/10.48550/arXiv.1804.06896gydF4y2Ba(2018)。gydF4y2Ba

蔡强,等。强化学习驱动的启发式优化。gydF4y2BaarXivgydF4y2Bahttps://doi.org/10.48550/arXiv.1906.06639gydF4y2Ba(2019).gydF4y2Ba

连接主义强化学习的简单统计梯度跟随算法。gydF4y2Ba马赫。学习。gydF4y2Ba8gydF4y2Ba, 229-256(1992)。gydF4y2Ba

短程分子动力学的快速并行算法。gydF4y2Baj .第一版。理论物理。gydF4y2Ba117gydF4y2Ba, 1-19(1995)。gydF4y2Ba

Chenoweth, K, Van Duin, A. C. & Goddard, W. A. ReaxFF反应力场在烃类氧化分子动力学模拟中的应用。gydF4y2Ba期刊。化学。一个gydF4y2Ba112gydF4y2Ba, 1040-1053(2008)。gydF4y2Ba

陈忠,卡杰,A, Martini, A,和Kim, S. H.确定摩擦的物理和化学贡献:化学惰性和活性石墨烯台阶边缘的比较研究。gydF4y2BaACS达成。板牙。接口gydF4y2Ba12gydF4y2Ba, 30007-30015(2020)。gydF4y2Ba

瓦希思,A.等。激光诱导石墨烯(LIG)形成多功能聚合物纳米复合材料的ReaxFF模拟。gydF4y2BaACS达成。纳米板牙。gydF4y2Ba3.gydF4y2Ba, 1881-1890(2020)。gydF4y2Ba

Berman, D, Deshmukh, S. A., Sankaranarayanan, S. K. R. S., Erdemir, A.和Sumant, A. V.石墨烯纳米卷形成的宏观超润滑性能。gydF4y2Ba科学gydF4y2Ba348gydF4y2Ba, 1118-1122(2015)。gydF4y2Ba

Yoon, K., Ostadhossein, A. & van Duin, A. C. T.纳米弹丸冲击下石墨烯化学力学行为的原子尺度模拟。gydF4y2Ba碳gydF4y2Ba99gydF4y2Ba, 58-64(2016)。gydF4y2Ba

典型动力学:平衡相空间分布。gydF4y2Ba理论物理。启一个gydF4y2Ba31gydF4y2Ba, 1695-1697(1985)。gydF4y2Ba

白慧,李春春,王晓,史国光,一种ph敏感的氧化石墨烯复合水凝胶。gydF4y2Ba化学。Commun。gydF4y2Ba46gydF4y2Ba科学通报,2376-2378(2010)。gydF4y2Ba

张丹,童军,夏斌,薛强。基于氧化石墨烯/聚电解质纳米复合膜逐层自组装的超高性能湿度传感器。gydF4y2Ba传感器,执行器B,化学。gydF4y2Ba203gydF4y2Ba, 263-270(2014)。gydF4y2Ba

致谢gydF4y2Ba

本工作使用了由美国国家科学基金会(基金号:ACI-1548562)支持的极限科学与工程发现环境(XSEDE)桥梁系统。作者感谢Alfred P. Sloan基金会和美国国家科学基金会(基金编号:DMREF-2119276)的支持。gydF4y2Ba

作者信息gydF4y2Ba

作者及单位gydF4y2Ba

贡献gydF4y2Ba

所有作者都参与了研究的构思和设计、数据分析和手稿的撰写。gydF4y2Ba

相应的作者gydF4y2Ba

道德声明gydF4y2Ba

相互竞争的利益gydF4y2Ba

作者声明没有利益冲突。gydF4y2Ba

额外的信息gydF4y2Ba

出版商的注意gydF4y2Bab施普林格《自然》杂志对已出版的地图和机构的管辖权要求保持中立。gydF4y2Ba

补充信息gydF4y2Ba

41524 _2022_919_moesm1_esm.pdfgydF4y2Ba

如果gydF4y2Ba

权利和权限gydF4y2Ba

开放获取gydF4y2Ba本文遵循知识共享署名4.0国际许可协议,该协议允许以任何媒介或格式使用、共享、改编、分发和复制,只要您适当地注明原作者和来源,提供知识共享许可协议的链接,并注明是否进行了更改。本文中的图像或其他第三方材料包含在文章的知识共享许可协议中,除非在材料的署名中另有说明。如果材料未包含在文章的知识共享许可中,并且您的预期用途不被法律法规允许或超过允许的用途,您将需要直接从版权所有者处获得许可。要查看此许可证的副本,请访问gydF4y2Bahttp://creativecommons.org/licenses/by/4.0/gydF4y2Ba。gydF4y2Ba

关于本文gydF4y2Ba

引用本文gydF4y2Ba

郑斌,郑铮,顾国祥。基于深度强化学习的机械韧性氧化石墨烯材料设计。gydF4y2Banpj计算机材料gydF4y2Ba8gydF4y2Ba, 225(2022)。https://doi.org/10.1038/s41524-022-00919-zgydF4y2Ba

收到了gydF4y2Ba:gydF4y2Ba

接受gydF4y2Ba:gydF4y2Ba

发表gydF4y2Ba:gydF4y2Ba

DOIgydF4y2Ba:gydF4y2Bahttps://doi.org/10.1038/s41524-022-00919-zgydF4y2Ba