数据集对于训练和验证机器学习算法是必不可少的。但这些数据通常来自互联网,因此它们编码了社会中存在的所有刻板印象、不平等和权力不对称。这些偏见被使用它们的算法系统加剧了,这意味着系统的输出本质上是歧视性的,在数据集被审计并以某种方式纠正之前,将继续存在问题和潜在的危害。尽管这种情况一直存在,但克服这一问题的第一个主要步骤只是在四年前,当时Joy Buolamwini和Timnit Gebru1发表了一份报告,引发了人工智能(AI)伦理的全面变革。

阅读论文:性别阴影:商业性别分类的交叉准确性差异

作为一名计算机科学专业的研究生,Buolamwini对商业面部识别系统无法在照片和视频片段中识别她的脸感到沮丧。她推测,这在一定程度上是因为深色皮肤的面孔没有出现在她正在研究的训练计算机程序的数据集中。这一见解促使Buolamwini和她的合作者Gebru对商业面部分析系统进行了系统审计,并证明这种系统根据图像中人的肤色和性别表现不同。这项工作后来被称为“性别阴影”审计。

作者首先使用皮肤科医生批准的皮肤类型分类系统来评估IJB-A和Adience两个图像库的组成,这两个图像库在当时被广泛用于训练面部识别软件。他们发现,在IJB-A中,浅色皮肤的人占79.6%,而在Adience中,这一比例为86.2%。这促使Buolamwini和Gebru编译了他们自己的一组图像——一组比现有选项提供的肤色范围更广的图像,并且包含了相似数量的男性和女性(商业算法通常无法处理非二元分类)。为此,他们研究了来自国家议会中性别平等的国家的政治家的照片。由此产生的数据集被称为试点议会基准(图1),包含来自卢旺达、塞内加尔、南非、冰岛、芬兰和瑞典的1,270人的图像。

图1 |一个性别平衡的面部图像库,具有一系列肤色。Buolamwini和Gebru意识到深色皮肤的面孔在用于训练面部识别软件的图像数据集中代表不足1他们使用来自国家议会中性别平等的国家的政治家的照片汇编了自己的数据集。这是一个“平均”脸的子集,混合了来自完整数据集的许多图像,该数据集包括来自卢旺达、塞内加尔、南非、冰岛、芬兰和瑞典的1270个人的照片。Buolamwini和Gebru使用他们的数据集表明,三种商业性别分类系统对深色皮肤的女性进行了错误分类,错误率远远高于浅色皮肤的男性。图片来源:Joy Buolamwini博士CC 4.0)

随后,布拉姆维尼和格布鲁用他们的基准集评估了由微软、face++和IBM技术公司开发的三种商业性别分类系统。作者没有根据性别或皮肤类型来评估这些系统的准确性,而是比较了分类器在四个交叉组中的表现,他们称之为深肤色女性、深肤色男性、浅肤色女性和浅肤色男性。他们发现,肤色较深的女性最容易被错误分类,最大分类错误率为34.7%;相比之下,浅肤色男性的最大错误率为0.8%。这三种系统对黑皮肤女性的准确率都很差,而对白人男性的准确率则高得多。

有影响力的研究并不总是第一眼就被理解和认可,特别是当它挑战传统思维时。在论文发表时,Buolamwini和Gebru的论文不仅在计算机视觉(研究如何使计算机自动化人类视觉系统执行的任务)领域被认为是一个异类,而且在人工智能伦理领域也被视为一个异类。从那以后,发生了很多变化,算法审计迅速成为一种重要的实践,促使学术期刊和会议强调审计研究。

性别阴影审计在研究中的下游效应也可以在大规模数据集的管理实践中找到。例如,今年早些时候报道的一项倡议表明,大型图像库中的人脸,如流行的ImageNet (go.nature.com/3qukjkn),以保护个人的私隐2.该研究表明,图像中脸部的模糊或马赛克对识别图像其他元素的软件的准确性几乎没有影响。但作者也指出,这项工作必须通过众包来完成,而不是使用商业软件,以避免性别阴影研究揭示的种族偏见。

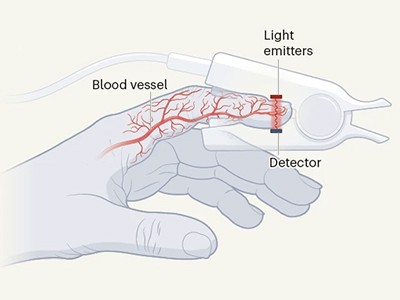

皮肤颜色影响医用氧传感器的准确性

尽管一开始有人反对Buolamwini和Gebru的论文,但他们审核的面部识别软件的供应商最终做出了积极的回应。例如,IBM和微软承诺测试他们的面部识别算法,并使他们的训练数据集多样化(例如,go.nature.com/3rmbo17).在这篇论文发表大约一年后,一项后续审计发现,微软、IBM和face++都成功地减少了其面部分析产品的性能错误3..最值得注意的改进是,在试点议会基准集中,face++软件识别深色女性面孔的错误减少了30.4%,微软和IBM算法在这项任务中分别提高了19.28%和17.73%。

但这些系统都没有完全克服种族偏见,许多公司已经停止或暂时停止了面部识别技术。越来越多的证据表明,人工智能模型错误地将黑人图像与“大猩猩”或“黑猩猩”等动物类别联系在一起的频率,高于非黑人图像4.

这项研究还影响了面部分析技术的监管方式。在美国,2019年的《算法问责法》授权联邦贸易委员会(负责促进和执行消费者保护的机构)监管自动决策系统(go.nature.com/3xguff7).加利福尼亚州的旧金山、马萨诸塞州的波士顿和俄勒冈州的波特兰等美国城市已禁止警方使用面部识别技术,理由是有偏见的错误识别会对有色人种社区造成不成比例的影响。在欧洲,民间社会组织、活动人士和技术专家已经联合起来呼吁禁止面部识别分析(go.nature.com/3qwzmnq)及一般生物识别技术(例如o.nature.com/3f7jrka).欧盟人工智能法案初稿(go.nature.com/3dtgh4x),表明在公共场所实时使用面部识别可能会受到限制。

法规和责任风险促使大公司改变他们的做法,但即使是最小的法规也在被破坏(go.nature.com/3yb96kq).尽管这样的威慑可以带来明显改善的结果,但鉴于面部分析技术的普及,最具有长期影响的变化可能来自公众态度的转变——我认为Buolamwini和Gebru的研究已经直接和间接地影响了这一点。这项工作甚至成为了2020年纪录片的主题编码的偏见(go.nature.com/3fashnf).不幸的是,这些作者(像许多其他黑人女性学者一样)也被主流媒体忽视了:例如,2021年关于面部分析技术中的种族偏见的电视片段未能认可她们及其合作者的工作(go.nature.com/3satrp8).

在过去的几年里,由这项工作引发的讨论已经从关注面部识别算法的准确性和性能,转移到围绕监控技术的更大、更基本的问题。当这项技术被用来从外表测量内在行为时,精确度的问题就变得毫无意义了。事实上,“准确”的表现可以归结为将这些行为简化为过时的社会刻板印象5.

一些声称可以检测情绪、预测性别或衡量某人可信度的算法被一些人称为“人工智能蛇油”。go.nature.com/3rh7cfp),因为这些社会文化属性无法从面部、表情或手势中可靠地推断出来6.另一些人则呼吁全面禁止面部识别算法,称该技术复兴了面相学和颅相学等伪科学7.

ImageNet数据集是一个大规模的图像集合,被认为是计算机视觉的黄金标准,在过去十年将计算机视觉研究定位为“深度学习革命”的核心方面发挥了关键作用。面部识别技术随后成为主流,并在几乎所有的社会和公共空间普遍存在,包括音乐会场地、学校、机场、社区和公共广场——这严重损害了隐私,并导致了令人担忧的监视行为。即使新的算法是基于不同的图像集(如试点议会基准)设计的,它们仍然很容易被用于固有的有害和压迫性的目的,如监视少数族裔社区。

面部识别技术已经扩展到其他研究领域,比如通过DNA分析预测面部特征的研究8以及其他旨在仅从人脸图像实现医疗诊断自动化的项目9.鉴于面部识别算法中固有的种族偏见,这些进展令人担忧。

在公众对新AI技术热情高涨的情况下,Buolamwini和Gebru发起了一系列批评工作,揭露了面部分析算法的偏见、歧视和压迫性。他们的审计在四年前是开创性的,现在仍然是一个有影响力的参照点,以对抗这项技术的快速发展及其构成的威胁。

结束种族主义是更好科学的关键:《自然》客座编辑的信息

结束种族主义是更好科学的关键:《自然》客座编辑的信息 “这是一种持续的嗡嗡声”:一位行星地质学家大声疾呼学术界的种族主义

“这是一种持续的嗡嗡声”:一位行星地质学家大声疾呼学术界的种族主义 加拿大首位土著女外科医生正在为健康正义而战

加拿大首位土著女外科医生正在为健康正义而战 为大学对抗系统性种族主义而奋斗的地球科学家

为大学对抗系统性种族主义而奋斗的地球科学家 “没有我们的空间”:一位澳大利亚土著健康研究人员与种族主义作斗争

“没有我们的空间”:一位澳大利亚土著健康研究人员与种族主义作斗争 “我被对待得好像我很脏一样”:一位儿科医生谴责针对非洲科学家的种族主义

“我被对待得好像我很脏一样”:一位儿科医生谴责针对非洲科学家的种族主义 计算机科学存在种族歧视问题:这些研究人员想要解决这个问题

计算机科学存在种族歧视问题:这些研究人员想要解决这个问题 反对极端分子将基因研究武器化

反对极端分子将基因研究武器化 皮肤颜色影响医用氧传感器的准确性

皮肤颜色影响医用氧传感器的准确性 帝国主义的长期阴影:英国大学努力应对殖民历史

帝国主义的长期阴影:英国大学努力应对殖民历史 一位牙买加药用植物科学家探索他的非洲根

一位牙买加药用植物科学家探索他的非洲根 是时候规范解读人类情绪的人工智能了

是时候规范解读人类情绪的人工智能了 面部识别研究需要伦理上的考量

面部识别研究需要伦理上的考量